Рассматривается задача классификация изображений, хранимых наборами данных MNIST [1], EMNIST-letters [2] и CIFAR-10 [3].

Решаются следующие задачи:

Модели НС реализуются на языке программирования Python средствами библиотеки Keras.

Обучаются разные модели НС с применением различных функций потерь, предоставляемых библиотекой Keras.

Качество обучения оценивается по трем следующим критериям:

При представлении результатов обучения с целью повышения наглядности используется показатель "суммарное число ошибочно классифицированных изображений на тестовых и обучающих данных.

Наборы данных содержат следующие изображения:

Замечание. Далее вместо EMNIST-letters будет употребляться EMNIST.

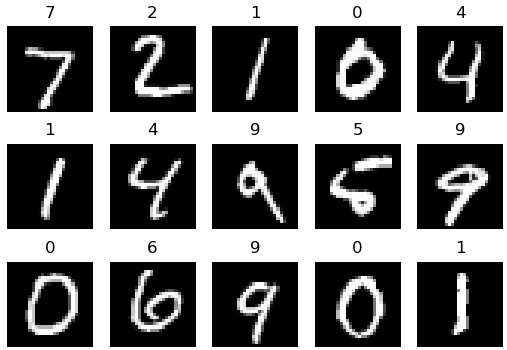

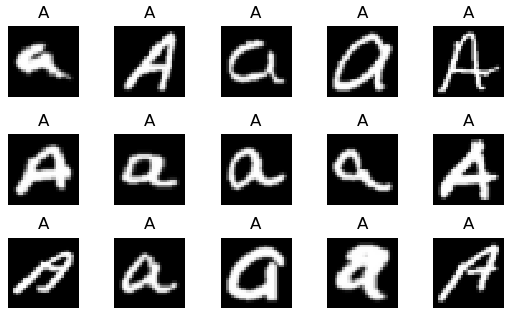

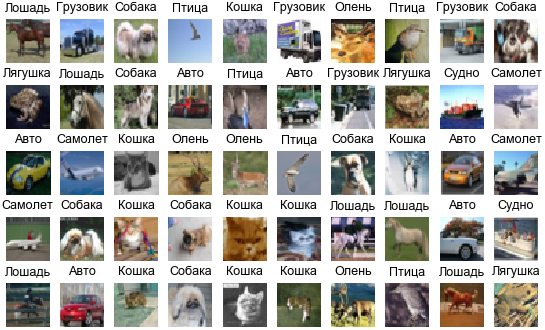

Примеры изображений наборов данных приведены на рис. 1-3.

Рис. 1. MNIST: примеры изображений

Рис. 2. EMNIST: примеры изображений буквы A

Рис. 3. CIFAR-10: примеры изображений

При необходимости здесь можно загрузить файлы с данными:

В случае MNIST данные загружаются из следующих файлов:

Загрузку и вывод девяти цифр обучающего набора MNIST обеспечивает следующий код:

from mnist import MNIST

import numpy as np

import matplotlib.pyplot as plt

pathToData = 'G:\\AM\\НС\\mnist\\'

mndata = MNIST(pathToData) # pathToData – ранее заданный путь к папке с данными

mndata.gz = True # Разрешаем чтение архивированных данных

imagesTrain, labelsTrain = mndata.load_training()# Обучающая выборка (данные и метки)

imagesTest, labelsTest = mndata.load_testing()# Тестовая выборка (данные и метки)

X_train = np.asarray(imagesTrain)

y_train = np.asarray(labelsTrain)

X_train = X_train.reshape(X_train.shape[0], 28, 28, 1)

# Выводим 9 изображений обучающего набора

names = []

for i in range(10): names.append(chr(48 + i)) # ['0', '1', '2', ..., '9']

for i in range(9):

plt.subplot(3, 3, i + 1)

ind = y_train[i]

img = X_train[i][0:28, 0:28, 0]

plt.imshow(img, cmap = plt.get_cmap('gray'))

plt.title(names[ind])

plt.axis('off')

plt.subplots_adjust(hspace = 0.5)

plt.show()

При работе с EMNIST использованы те же средства ввода данных, что и для MNIST. Для этого выполнены приведенные в табл. 1 изменения имен файлов EMNIST (тип файлов – gz Archive):

Таблица 1. Переименования имен файлов EMNIST

| Исходное имя файла | Имя после переименования | Размер архива (КБ) |

|---|---|---|

| EMNIST-train-images-idx3-ubyte | train-images-idx3-ubyte | 30'883 |

| EMNIST-train-labels-idx1-ubyte | train-labels-idx1-ubyte | 78 |

| EMNIST-test-images-idx3-ubyte | t10k-images-idx3-ubyte | 4'922 |

| EMNIST-test-labels-idx1-ubyte | t10k-labels-idx1-ubyte | 1 |

Различия при вводе данных обусловлены тем, что в EMNIST буквы хранятся в горизонтальном положении и вдобавок отраженными относительно оси x (рис. 4).

Рис. 4. Буквы EMNIST без преобразований отражения и поворота

В программе после чтения файла буквы отражаются относительно оси x и поворачиваются на 90° по часовой стрелке:

X_train = X_train.reshape(X_train.shape[0], img_rows, img_cols, 1).transpose(0,2,1,3)

X_test = X_test.reshape(X_test.shape[0], img_rows, img_cols, 1).transpose(0,2,1,3)

В принципе, сеть можно обучать, не подвергая таким преобразованиям обучающую и тестовую выборки, а выполнять эти преобразования лишь при выводе рисунков букв:

import numpy as np

from scipy import ndimage

...

let = X_test[0][0:28, 0:28, 0] # Первая буква тестового набора

let = let.reshape(32, 32)

let = np.flipud(let)

let = ndimage.rotate(let, -90)

или

let = let.reshape(32, 32).transpose()

Ввод данных будет выполнен быстрее, если их загружать из бинарных файлов.

Архивы таких файлов имеются для MNIST и EMNIST.

Код создания MNIST-бинарных файлов:

from mnist import MNIST

import numpy as np

# Прежде загружаем данные

mndata = MNIST(pathToData)

mndata.gz = True

imagesTrain, labelsTrain = mndata.load_training()

imagesTest, labelsTest = mndata.load_testing()

# Сохраняем данные в двоичные файлы

fn = open(pathToData + 'imagesTrain.bin', 'wb')

fn2 = open(pathToData + 'labelsTrain.bin', 'wb')

fn3 = open(pathToData + 'imagesTest.bin', 'wb')

fn4 = open(pathToData + 'labelsTest.bin', 'wb')

fn.write(np.uint8(imagesTrain))

fn2.write(np.uint8(labelsTrain))

fn3.write(np.uint8(imagesTest))

fn4.write(np.uint8(labelsTest))

fn.close()

fn2.close()

fn3.close()

fn4.close()

print('MNIST-данные сохранены в двоичные файлы')

Код чтения бинарных файлов (предварительно выполняется распаковка ранее загруженного архива с бинарными файлами):

def loadBinData(pathToData):

import numpy as np

print('Загрузка данных из двоичных файлов')

with open(pathToData + 'imagesTrain.bin', 'rb') as read_binary:

data = np.fromfile(read_binary, dtype = np.uint8)

with open(pathToData + 'labelsTrain.bin', 'rb') as read_binary:

labels = np.fromfile(read_binary, dtype = np.uint8)

with open(pathToData + 'imagesTest.bin', 'rb') as read_binary:

data2 = np.fromfile(read_binary, dtype = np.uint8)

with open(pathToData + 'labelsTest.bin', 'rb') as read_binary:

labels2 = np.fromfile(read_binary, dtype = np.uint8)

return data, labels, data2, labels2

#

pathToData = 'G:\\AM\\НС\\mnist\\'

imagesTrain, labelsTrain, imagesTest, labelsTest = loadBinData(pathToData)

X_train = np.asarray(imagesTrain)

y_train = np.asarray(labelsTrain)

X_test = np.asarray(imagesTest)

y_test = np.asarray(labelsTest)

X_train = X_train.reshape(-1, 28, 28, 1)

X_test = X_test.reshape(-1, 28, 28, 1)

CIFAR-10 загружается из файлов, расположенных в папке

pathToData + cifar-10-batches-py/

В этой папке файлы

data_batch_1, data_batch_2, data_batch_3, data_batch_4, data_batch_5

содержат обучающие данные, а файл

test_batch

содержит тестовые данные.

Размер каждого файла 30'309 КБ. Каждый файл содержит по 10'000 изображений и их метки.

Код загрузки CIFAR-10 и вывода 50-и случайных изображений обучающего набора:

import numpy as np

import matplotlib.pyplot as plt

import matplotlib.font_manager as font_manager

#

def load_cifar10(pathToData): # pathToData – путь к папке с данными

def unpickle(file):

import pickle

with open(file, 'rb') as fo:

dict_file = pickle.load(fo, encoding = 'bytes')

return dict_file

fileNm = pathToData + 'cifar-10-batches-py/data_batch_'

# Загрузка обучающих данных

im_size = 32 * 32 * 3 # 3072

X_train = np.zeros((50000, im_size), dtype = 'uint8')

y_train = np.zeros(50000, dtype = 'uint8')

m = -1

for i in range(5):

dict_i = unpickle(fileNm + str(i + 1))

X = dict_i[b'data']

Y = dict_i[b'labels']

Y = np.array(Y)

for k in range(10000):

m += 1

X_train[m, :] = X[k, :]

y_train[m] = Y[k]

X_train = X_train.reshape(-1, 3, 32, 32).transpose(0,2,3,1)

# Загрузка тестовых данных

len_test = 10000

fileNm = pathToData + 'cifar-10-batches-py/test_batch'

dict_i = unpickle(fileNm)

X_test = dict_i[b'data']

y_test = dict_i[b'labels']

X_test = X_test.reshape(len_test, 3, 32, 32).transpose(0,2,3,1) # .astype('uint8')

y_test = np.array(y_test)

# Выводим 50 случайных изображений обучающего набора

names = []

names.append('Самолет')

names.append('Авто')

names.append('Птица')

names.append('Кошка')

names.append('Олень')

names.append('Собака')

names.append('Лягушка')

names.append('Лошадь')

names.append('Судно')

names.append('Грузовик')

fig, axs = plt.subplots(5, 10, figsize = (7, 4))

title_font = {'fontname':'Arial', 'size':'9', 'color':'black'}

for j in range(5):

for k in range(10):

i = np.random.choice(range(50000))

ax1 = axs[j][k]

ax1.set_axis_off()

ax1.imshow(X_train[i])

ax1.set_title(names[y_train[i]], **title_font)

plt.subplots_adjust(hspace = 0.5, wspace = 0.0)

plt.show()

pathToData = 'G:\\AM\\НС\\cifar10\\'

load_cifar10(pathToData)

Обучение моделей НС выполняется с различными функциями потерь библиотеке Keras [4] на наборах данных MNIST, EMNIST и CIFAR-10.

Используемые функции потерь и их обозначения перечислены в табл. 2.

Таблица 2. Функции потерь библиотеки Keras

| № | Функция | Обозначение |

|---|---|---|

| 1 | Средняя квадратическая ошибка / mean squared error | mse |

| 2 | Средняя абсолютная ошибка / mean absolute error | mae |

| 3 | Средняя абсолютная процентная ошибка / mean absolute percentage error | mape |

| 4 | Средняя квадратическая логарифмическая ошибка / mean squared logarithmic error | msle |

| 5 | Квадрат верхней границы / squared hinge | sh |

| 6 | Верхняя граница / hinge | h |

| 7 | Категориальная верхняя граница / categorical hinge | ch |

| 8 | Логарифм гиперболического косинуса / logcosh | lc |

| 9 | Категориальная перекрестная энтропия / categorical crossentropy | cce |

| 10 | Разреженная категориальная перекрестная энтропия / sparse categorical crossentropy | scce |

| 11 | Бинарная перекрестная энтропия / binary crossentropy | bce |

| 12 | Расстояние Кульбака-Лейблера / kullback leibler divergence | kld |

| 13 | Пуассон / Poisson | pss |

| 14 | Косинусная близость / cosine proximity | cp |

Кроме перечисленных в табл. 2. функций потерь, применяются:

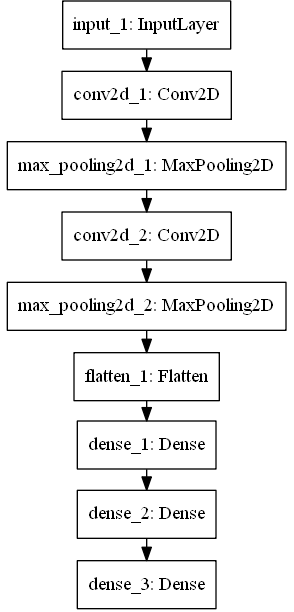

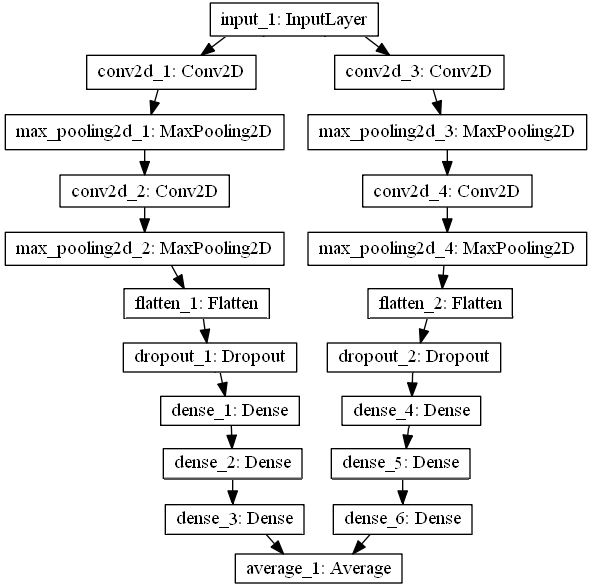

Классификация изображений MNIST, EMNIST и CIFAR-10 выполняется с использованием сверточных НС (СНС), созданных на основе структуры, приведенной на рис. 5.

Рис. 5. Структура базовой СНС для MNIST, EMNIST и CIFAR-10

Построение СНС выполнялось в результате добавления слоев (сверточных, полносвязных, разреживающих и пакетной нормализации), также использовались и сборки СНС с двумя и тремя ветвями.

Поскольку СНС, построенные на базе приведенной на рис. 5 структуры, показали низкие результаты обучения на CIFAR-10, вдобавок была использована сеть ReNet20v1, показывающая, согласно [5], на CIFAR-10 точность классификации 91.25% на проверочных данных.

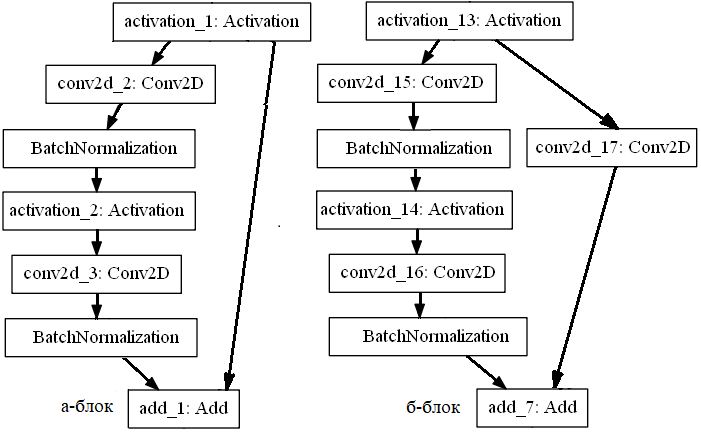

ReNet20v1 состоит секций, содержащих показанные на рис. 6 блоки.

Рис. 6. Блоки секций ResNet20v1

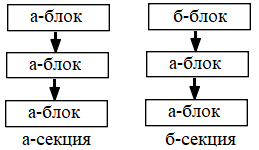

Всего в ReNet20v1 три секции. Первая секция состоит из трех а-блоков, вторая и третья – из б-блока и двух а-блоков (рис. 7).

Рис. 7. Структуры секций ResNet20v1

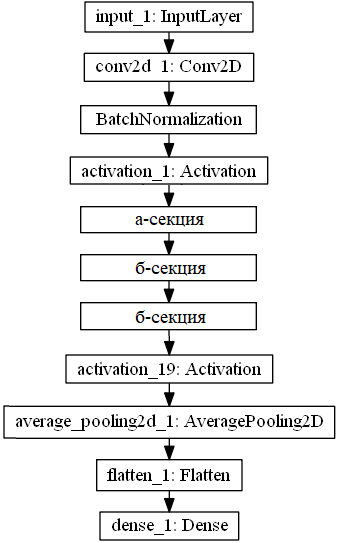

Полностью структура ReNet20v1 показана на рис. 8.

Рис. 8. Структура ResNet20v1

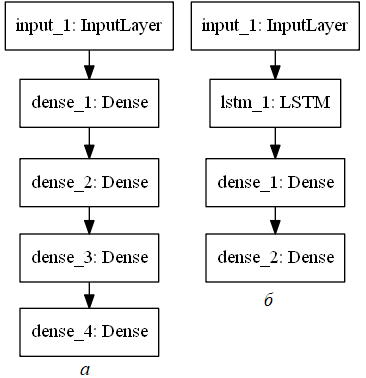

Кроме того, для MNIST использовались модели многослойного перцептрона (МП) и рекуррентной нейронной сети (РНС) с LSTM-слоем (рис. 9).

Рис. 9. Структуры НС: а – МП; б – РНС

Для вывода рис. 5 и 9 использована процедура plot_model:

import keras

from keras.utils import plot_model

model = createModel() # Формирование модели СНС

plot_model(model, to_file = 'cnn_graph.png') # Вывод графа модели СНС

Замечание. Для plot_model необходимо установить graphviz (нужна библиотека gvc.dll).

В MNIST и EMNIST изображения заданы в оттенках серого цвета на площадке размером 28*28 пикселей, что определяет следующую форму входа:

input_shape = (28, 28, 1)

В CIFAR-10 изображения цветные и имеют размер 32*32 пикселя, поэтому задаем следующую форму входа:

input_shape = (32, 32, 3)

Форма выходного слоя определяется числом классов. В MNIST и CIFAR-10 их 10, а в EMNIST – 26.

В табл. 3 приведены описания слоев одной моделей НС, использованной для MNIST, EMNIST и CIFAR-10.

Таблица 3. Описание слоев СНС c4 для MNIST, EMNIST и CIFAR-10

| Layer (type) | Output Shape | Param # |

|---|---|---|

| input_1 (InputLayer) | MNIST, EMNIST: (None, 28, 28, 1) CIFAR-10: (None, 32, 32, 3) | 0 |

| conv2d_1 (Conv2D) | MNIST, EMNIST: (None, 28, 28, 20) CIFAR-10: (None, 32, 32, 20) | 340 560 |

| max_pooling2d_1 (MaxPooling2D) | MNIST, EMNIST: (None, 14, 14, 20) CIFAR-10: (None, 16, 16, 20) | 0 |

| conv2d_2 (Conv2D) | MNIST, EMNIST: (None, 14, 14, 30) CIFAR-10: (None, 16, 16, 30) | 9'630 5'430 |

| max_pooling2d_2 (MaxPooling2D) | MNIST, EMNIST: (None, 7, 7, 30) CIFAR-10: (None, 8, 8, 30) | 0 |

| flatten_1 (Flatten) | MNIST, EMNIST: (None, 1470) CIFAR-10: (None, 1920) | 0 |

| dense_1 (Dense) | (None, 600) | MNIST, EMNIST: 882'600 CIFAR-10: 1'152'600 |

| dense_2 (Dense) | MNIST: (None, 30) | MNIST, EMNIST: 18'030 CIFAR-10: 18'030 |

| dense_3 (Dense) | MNIST, CIFAR-10: (None, 10) EMNIST: (None, 26) | 310 806 |

| Total params (всего параметров): MNIST: 910'910 EMNIST: 911'406 CIFAR-10: 1'176'930 Trainable params (обучаемых параметров): MNIST: 910'910 EMNIST: 911'406 CIFAR-10: 1'176'930 Non-trainable params (необучаемых параметров): 0 | ||

Описание слоев ResNet20v1 приведено в табл. 4.

Таблица 4. Описание слоев ResNet20v1 для CIFAR-10

| Layer (type) | Output Shape | Param # | Connected to |

|---|---|---|---|

| input_1 (InputLayer) | (None, 32, 32, 3) | 0 | |

| conv2d_1 (Conv2D) | (None, 32, 32, 16) | 448 | input_1[0][0] |

| batch_normalization_1 (BatchNormalization) | (None, 32, 32, 16) | 64 | conv2d_1[0][0] |

| activation_1 (Activation) | (None, 32, 32, 16) | 0 | batch_normalization_1[0][0] |

| conv2d_2 (Conv2D) | (None, 32, 32, 16) | 2'320 | activation_1[0][0] |

| batch_normalization_2 (BatchNormalization) | (None, 32, 32, 16) | 64 | conv2d_2[0][0] |

| activation_2 (Activation) | (None, 32, 32, 16) | 0 | batch_normalization_2[0][0] |

| conv2d_3 (Conv2D) | (None, 32, 32, 16) | 2'320 | activation_2[0][0] |

| batch_normalization_3 (BatchNormalization) | (None, 32, 32, 16) | 64 | conv2d_3[0][0] |

| add_1 (Add) | (None, 32, 32, 16) | 0 | activation_1[0][0] batch_normalization_3[0][0] |

| activation_3 (Activation) | (None, 32, 32, 16) | 0 | add_1[0][0] |

| conv2d_4 (Conv2D) | (None, 32, 32, 16) | 2'320 | activation_3[0][0] |

| batch_normalization_4 (BatchNormalization) | (None, 32, 32, 16) | 64 | conv2d_4[0][0] |

| activation_4 (Activation) | (None, 32, 32, 16) | 0 | batch_normalization_4[0][0] |

| conv2d_5 (Conv2D) | (None, 32, 32, 16) | 2'320 | activation_4[0][0] |

| batch_normalization_5 (BatchNormalization) | (None, 32, 32, 16) | 64 | conv2d_5[0][0] |

| add_2 (Add) | (None, 32, 32, 16) | 0 | activation_3[0][0] batch_normalization_5[0][0] |

| activation_5 (Activation) | (None, 32, 32, 16) | 0 | add_2[0][0] |

| conv2d_6 (Conv2D) | (None, 32, 32, 16) | 2'320 | activation_5[0][0] |

| batch_normalization_6 (BatchNormalization) | (None, 32, 32, 16) | 64 | conv2d_6[0][0] |

| activation_6 (Activation) | (None, 32, 32, 16) | 0 | batch_normalization_6[0][0] |

| conv2d_7 (Conv2D) | (None, 32, 32, 16) | 2'320 | activation_6[0][0] |

| batch_normalization_7 (BatchNormalization) | (None, 32, 32, 16) | 64 | conv2d_7[0][0] |

| add_3 (Add) | (None, 32, 32, 16) | 0 | activation_5[0][0] batch_normalization_7[0][0] |

| activation_7 (Activation) | (None, 32, 32, 16) | 0 | add_3[0][0] |

| conv2d_8 (Conv2D) | (None, 16, 16, 32) | 4'640 | activation_7[0][0] |

| batch_normalization_8 (BatchNormalization) | (None, 16, 16, 32) | 128 | conv2d_8[0][0] |

| activation_8 (Activation) | (None, 16, 16, 32) | 0 | batch_normalization_8[0][0] |

| conv2d_9 (Conv2D) | (None, 16, 16, 32) | 9'248 | activation_8[0][0] |

| conv2d_10 (Conv2D) | (None, 16, 16, 32) | 544 | activation_7[0][0] |

| batch_normalization_9 (BatchNormalization) | (None, 16, 16, 32) | 128 | conv2d_9[0][0] |

| add_4 (Add) | (None, 16, 16, 32) | 0 | conv2d_10[0][0] batch_normalization_9[0][0] |

| activation_9 (Activation) | (None, 16, 16, 32) | 0 | add_4[0][0] |

| conv2d_11 (Conv2D) | (None, 16, 16, 32) | 9'248 | activation_9[0][0] |

| batch_normalization_10 (BatchNormalization) | (None, 16, 16, 32) | 128 | conv2d_11[0][0] |

| activation_10 (Activation) | (None, 16, 16, 32) | 0 | batch_normalization_10[0][0] |

| conv2d_12 (Conv2D) | (None, 16, 16, 32) | 9'248 | activation_10[0][0] |

| batch_normalization_11 (BatchNormalization) | (None, 16, 16, 32) | 128 | conv2d_12[0][0] |

| add_5 (Add) | (None, 16, 16, 32) | 0 | activation_9[0][0] batch_normalization_11[0][0] |

| activation_11 (Activation) | (None, 16, 16, 32) | 0 | add_5[0][0] |

| conv2d_13 (Conv2D) | (None, 16, 16, 32) | 9'248 | activation_11[0][0] |

| batch_normalization_12 (BatchNormalization) | (None, 16, 16, 32) | 128 | conv2d_13[0][0] |

| activation_12 (Activation) | (None, 16, 16, 32) | 0 | batch_normalization_12[0][0] |

| conv2d_14 (Conv2D) | (None, 16, 16, 32) | 9'248 | activation_12[0][0] |

| batch_normalization_13 (BatchNormalization) | (None, 16, 16, 32) | 128 | conv2d_14[0][0] |

| add_6 (Add) | (None, 16, 16, 32) | 0 | activation_11[0][0] batch_normalization_13[0][0] |

| activation_13 (Activation) | (None, 16, 16, 32) | 0 | add_6[0][0] |

| conv2d_15 (Conv2D) | (None, 8, 8, 64) | 18'496 | activation_13[0][0] |

| batch_normalization_14 (BatchNormalization) | (None, 8, 8, 64) | 256 | conv2d_15[0][0] |

| activation_14 (Activation) | (None, 8, 8, 64) | 0 | batch_normalization_14[0][0] |

| conv2d_16 (Conv2D) | (None, 8, 8, 64) | 36'928 | activation_14[0][0] |

| conv2d_17 (Conv2D) | (None, 8, 8, 64) | 2'112 | activation_13[0][0] |

| batch_normalization_15 (BatchNormalization) | (None, 8, 8, 64) | 256 | conv2d_16[0][0] |

| add_7 (Add) | (None, 8, 8, 64) | 0 | conv2d_17[0][0] batch_normalization_15[0][0] |

| activation_15 (Activation) | (None, 8, 8, 64) | 0 | add_7[0][0] |

| conv2d_18 (Conv2D) | (None, 8, 8, 64) | 36'928 | activation_15[0][0] |

| batch_normalization_16 (BatchNormalization) | (None, 8, 8, 64) | 256 | conv2d_18[0][0] |

| activation_16 (Activation) | (None, 8, 8, 64) | 0 | batch_normalization_16[0][0] |

| conv2d_19 (Conv2D) | (None, 8, 8, 64) | 36'928 | activation_16[0][0] |

| batch_normalization_17 (BatchNormalization) | (None, 8, 8, 64) | 256 | conv2d_19[0][0] |

| add_8 (Add) | (None, 8, 8, 64) | 0 | activation_15[0][0] batch_normalization_17[0][0] |

| activation_17 (Activation) | (None, 8, 8, 64) | 0 | add_8[0][0] |

| conv2d_20 (Conv2D) | (None, 8, 8, 64) | 36'928 | activation_17[0][0] |

| batch_normalization_18 (BatchNormalization) | (None, 8, 8, 64) | 256 | conv2d_20[0][0] |

| activation_18 (Activation) | (None, 8, 8, 64) | 0 | batch_normalization_18[0][0] |

| conv2d_21 (Conv2D) | (None, 8, 8, 64) | 36'928 | activation_18[0][0] |

| batch_normalization_19 (BatchNormalization) | (None, 8, 8, 64) | 256 | conv2d_21[0][0] |

| add_9 (Add) | (None, 8, 8, 64) | 0 | activation_17[0][0] batch_normalization_19[0][0] |

| activation_19 (Activation) | (None, 8, 8, 64) | 0 | add_9[0][0] |

| average_pooling2d_1 (AveragePoo | (None, 1, 1, 64) | 0 | activation_19[0][0] |

| flatten_1 (Flatten) | (None, 64) | 0 | average_pooling2d_1[0][0] |

| dense_1 (Dense) | (None, 10) | 650 | flatten_1[0][0] |

| Total params: 274'442 Trainable params: 273'066 Non-trainable params: 1'376 | |||

Сведения, приведенные в табл. 3 и 4, получены в результате выполнения следующего кода:

model = createModel() # Формирование модели НС

model.summary() # Вывод сведений о слоях модели НС

Введем следующее полное обозначение слоя описанной в тпбл. 3 модели НС:

<Тип слоя>[<Вид функции активации>][<форма входа | число фильтров | нейронов>],

где <Тип слоя> – это символ I, C, D, P или F соответственно для входного, сверточного, полносвязного слоев или слоев подвыборки и преобразования многомерных данных в одномерные;

<Вид функции активации> – это символ R, L или S соответственно для функции активации ReLU, Linear или Softmax.

Для слоев типа P и F указанные в квадратных скобках компоненты обозначения отсутствуют.

Знак "|" использован для обозначения "или".

Запишем приведенные выше структуры СНС (кроме ResNet20v1) в виде следующих строк:

I(28,28,1)-CR20-P-CR30-P-F-DR600-DL30-DS10 # MNIST;

I(28,28,1)-CR20-P-CR30-P-F-DR600-DL30-DS26 # EMNIST;

I(32,32,3)-CR20-P-CR30-P-F-DR600-DL30-DS10 # CIFAR-10,

В дальнейшем, записывая таким образом структуру НС, будем опускать входной и выходной слои, например:

CR20-P-CR30-P-F-DR600-DL30.

Указание этой записи для MNIST означает, что на входе слой I(28,28,1), а на выходе DS10.

В случае EMNIST на входе I(28,28,1), а на выходе DS26.

В случае CIFAR-10 на входе I(32,32,3), а на выходе DS10.

Dropout-слой обозначается указанием параметра rate, задающего долю нейронов, исключаемых из модели НС, например, запись

CR20-P-CR30-P-F-0.25-DR600-DL16

означает, что перед полносвязным слоем

Dense(units = 600, activation = 'relu'...)

расположен слой

Dropout(rate = 0.25)

Присутствие слоя пакетной нормализации будем обозначать символами BN.

Обозначение LSTM-слоя рекуррентной сети (для слоя берется заданная по умолчанию функция активации):

Ln,

где n – размер выхода слоя.

Используя введенные обозначения, перечислим в табл. 5 модели НС, примененные для классификации изображений MNIST, EMNIST и CIFAR-10.

Таблица 5. Примененные модели НС

| № | Вид НС | Обозначение | Число параметров | Использование |

|---|---|---|---|---|

| c01 | Сверточная | CR32-P-CR64-P-F-DR1024-DL30 | 3'276'724 3'277'220 4'245'780 | MNIST EMNIST CIFAR-10 |

| c1 | тот же | CR32-P-CR64-P-F-0.35-DR1024-0.2-DL30 | то же | то же |

| c02 | тот же | CR32-P-CR64-P-F-DR1024-DL16 | 3'262'234 3'262'506 | MNIST EMNIST |

| c2 | тот же | CR32-P-CR64-P-F-0.35-DR1024-0.2-DL16 | то же | то же |

| c03 | тот же | CR32-P-CR64-P-F-DR1024-DL52 | 3'299'494 3'300'342 | MNIST EMNIST |

| c3 | тот же | CR32-P-CR64-P-F-0.35-DR1024-0.2-DL52 | то же | то же |

| c4 | тот же | CR20-P-CR30-P-F-DR600-DL30 | 910'910 911'406 1'176'930 | MNIST EMNIST CIFAR-10 |

| c5 | тот же | CR20-P-CR30-P-F-0.2-DR100 | 158'080 159'696 199'100 | MNIST EMNIST CIFAR-10 |

| c6 | тот же | CR20-P-CR30-P-F-DR600 | 898'580 | MNIST |

| c7 | тот же | CR10-P-CR15-P-F-0.2-DR300 | 226'395 231'211 292'955 | MNIST EMNIST CIFAR-10 |

| c8 | тот же | CR10-P-CR15-P-F-0.25-DR300-DL30 | 232'725 | MNIST |

| c9 | тот же | CR20-P-CR30-P-F-DR600-DL16 | 902'356 902'628 | MNIST EMNIST |

| c10 | тот же | CR20-P-CR30-P-F-DR600-DL52 | 924'352 925'200 | MNIST EMNIST |

| c11 | тот же | CR20-P-CR30-P-F-0.25-DR600-DL16 | 902'356 902'628 | MNIST EMNIST |

| c12 | тот же | CR20-P-CR30-P-F-0.25-DR600-0.2-DL16 | то же | то же |

| c12bn | тот же | C20-BN-R-P-C30-BN-R-P-F-0.25-D600-BN-R-0.2-D16-BN-L | 903'688 | MNIST |

| c13 | тот же | CR20-P-CR30-P-F-0.25-DR600-DL30 | 910'910 911'406 1'176'930 | MNIST EMNIST CIFAR-10 |

| c14 | тот же | CR20-P-CR30-P-F-0.25-DR600-0.2-DL30 | то же | то же |

| c15 | тот же | CR32-P-CR64-P-F-0.25-DR800-DL16 | 2'555'962 2'556'234 3'309'978 | MNIST EMNIST CIFAR-10 |

| c16 | тот же | CR32-P-CR64-P-F-0.25-DR800-0.2-DL16 | то же | то же |

| c17 | тот же | CR32-P-CR64-P-F-0.25-DR800-DL30 | 2'567'316 2'567'812 3'321'332 | MNIST EMNIST CIFAR-10 |

| c18 | тот же | CR32-P-CR64-P-F-0.25-DR800-0.25-DL30 | то же | то же |

| c19 | тот же | CR10-P-CR15-P-F-0.25-DR300 | 226'395 231'211 292'955 | MNIST EMNIST CIFAR-10 |

| c20 | тот же | CR10-P-CR15-P-F-0.3-DR300 | то же | то же |

| c21 | тот же | CR10-P-CR15-P-F-0.35-DR300 | то же | то же |

| c22 | тот же | CR10-P-CR15-P-F-0.35-DR300-0.3 | то же | то же |

| c23 | тот же | CR20-P-CR30-P-F-0.3-DR600-0.2-DL90-0.2 | 947'570 949'026 1'213'590 | MNIST EMNIST CIFAR-10 |

| c24 | тот же | CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 | то же | то же |

| c25 | тот же | CR20-P-CR30-P-F-DR600-DL60 | 929'240 930'216 1'195'260 | MNIST EMNIST CIFAR-10 |

| c26 | тот же | CR20-P-CR30-P-F-0.3-DR600-DL60 | то же | то же |

| c27 | тот же | CR20-P-CR30-P-F-0.3-DR600-0.2-DL60 | то же | то же |

| c28 | тот же | CR20-P-CR30-P-F-0.3-DR600-0.2-DL60-0.2 | то же | то же |

| c28bn | тот же | C20-BN-R-P-C30-BN-R-P-F-0.3-D600-BN-R-0.2-D60-BN-L-0.2 | 931'636 | EMNIST |

| c29 | тот же | CR10-P-CR15-P-F-0.3-DR300-0.25-DL50-0.2 | 238'945 239'761 305'505 | MNIST EMNIST CIFAR-10 |

| c30 | тот же | CR20-P-0.25-CR30-CR30-P-0.25-F-DR512-0.5 | 772'042 780'250 1'002'802 | MNIST EMNIST CIFAR-10 |

| c31 | тот же | CR15-P-CR10-P-F-0.4-DR300 | 152'975 157'971 197'090 | MNIST EMNIST CIFAR-10 |

| c32 | тот же | CR16-CR16-P-0.2-CR32-CR32-P-0.25-F-0.25-DR512-0.35-DR128-0.25 | 899'306 901'370 1'132'698 | MNIST EMNIST CIFAR-10 |

| c32 | тот же | CR16-CR16-P-0.2-CR32-CR32-P-0.25-F-0.25-DR512-0.35-DR128-0.25 | 899'306 901'370 1'132'698 | MNIST EMNIST CIFAR-10 |

| c33 | тот же | CR16-CR16-P-0.2-CR32-CR32-P-0.25-F-0.25-DR512-0.3-DL32-0.2 | 849'098 849'626 1'082'490 | MNIST EMNIST CIFAR-10 |

| c34 | тот же | C32-BN-R-C32-BN-R-P-0.25-C64-BN-R-C64-BN-R-P-0.25-F-D512-BN-R-0.5 | 1'728'074 1'736'282 2'169'770 | MNIST EMNIST CIFAR-10 |

| c35 | тот же | BN-CR32-CR32-P-0.25-BN-CR64-CR64-P-0.25-F-DR512-0.5-DR128-0.25 | 1'788'556 1'790'620 2'230'256 | MNIST EMNIST CIFAR-10 |

| c36 | тот же | ResNet20v1 | 272'778 273'818 273'066 | MNIST EMNIST CIFAR-10 |

| c37 | тот же | ResNet32v1 | 467'658 470'970 467'946 | MNIST EMNIST CIFAR-10 |

| m1 | МП | DR800-DR80-DL30 | 694'820 | MNIST |

| m2 | тот же | DR800-DR80-DL16 | 693'546 | MNIST |

| m3 | тот же | DR800-DR80-DL52 | 696'822 | MNIST |

| r1 | РНС | L300-DL30 | 404'140 | MNIST |

| r2 | тот же | L500-DL30 | 1'073'340 | MNIST |

В некоторых случаях используется сборка НС, построенная на основе одной из описанных в табл. 5 моделей НС (пример сборки показан на рис. 10).

Рис. 10. Сборочная НС (2c8) с двумя ветвями на основе сети c8

В этом случае перед в обозначении сборочной сети указывается число ветвей и обозначение базовой структуры, например, 2c8.

Для объединения идущих по ветвям сборки данных используется слой Average. Иные способы объединения данных описаны в [6].

Модель с конкретной функцией потерь обозначается следующим образом:

Результаты обучения перечисленных в табл. 5 моделей НС с применением разных функций потерь, приведены в прил. "Результаты обучения нейронных сетей".

В сетях различной структуры использованы следующие параметры:

Классификация изображений выполняется с применением перечисленных выше функций потерь.

В процессе обучения веса (параметры) модели НС будут записаны в файл после завершения эпохи, если результаты оценки НС по точности классификации на проверочных данных (monitor = 'val_acc') после этой эпохи превосходят ранее полученные результаты. Это обеспечивает следующий код:

# Обеспечим сохранение обученной сети

suf = 'MNIST_mape_Adam_conv_' # Значение suf может быть иным

filesToSave = 'weights_' + suff + '.{epoch:02d}-{val_acc:.2f}.hdf5'

say = 'веса' if weightsOnly else 'модель и веса'

print('Сохраняем веса в файлы вида ' + filesToSave)

pathWeights = pathToData + filesToSave

# Сохраняем и веса, и модель: save_weights_only = False

checkpoint = keras.callbacks.ModelCheckpoint(pathWeights, monitor = 'val_acc', verbose = 0,

save_weights_only = True,

save_best_only = True, mode = 'max', period = 1)

callbacks_list = [checkpoint]

# Обучение

# Запоминаем историю обучения для последующего анализа и вывода графиков потерь и точности

history = model.fit(X_train, y_train, batch_size = batch_size, epochs = epochs,

verbose = 2, validation_data = (X_test, y_test), callbacks = callbacks_list)

Пример имени файла с весами: weights_MNIST_mape_Adam_c12.36-0.99.hdf5

В имени файла указаны имя набора данных, применяемые функция потерь (mape) и метод оптимизации (Adam), обозначение НС (c12), номер эпохи, после завершения которой сохранены веса (36), и точность классификации на проверочных данных с двумя знаками после запятой.

Сохраненные веса модели НС (назовем ее исходной) можно загрузить в программу, предварительно создав модель НС, совпадающую с исходной. Кроме того, в создаваемую для загрузки весов модель НС можно добавить слои Dropout, либо исключить эти слои при их наличии в исходной модели или изменить некоторые параметры модели НС, например, функции активации, не влияющие на число весов в модели.

Модель с закруженными весами можно употребить для следующих целей:

По полученному массиву y_pred можно, в частности, получить индексы неверно классифицированных изображений и вывести ошибочный прогноз и истинное имя классса или его метку:

# X - тестируемые данные

# y - метки тестируемых данных

# n - число тестируемых данных

imgType = 'MNIST' # или 'EMNIST' или 'CIFAR10'

y_pred = model.predict(X) # Предсказания модели НС на обучающей или тестовой выборке

# Заносим в список classes метки классов, предсказанных моделью НС

classes = []

for m in y_pred: classes.append(np.argmax(m))

# Число верно классифицированных изображений

nClassified = np.sum(classes == y)

# Число ошибочно классифицированных изображений

nNotClassified = n - nClassified

acc = 100.0 * nClassified / n

print("Число ошибочно классифицированных образов: " + str(nNotClassified))

print("Точность прогнозирования: " + str(acc) + '%')

print('Список неверно классифицированных изображений')

names = [] # Список с именами классов

if imgType == 'MNIST':

for i in range(10): names.append(chr(48 + i)) # ['0', '1', '2', ..., '9']

elif imgType == 'EMNIST':

for i in range(26): names.append(chr(65 + i)) # ['A', 'B', 'C', ..., 'Z']

elif imgType == 'CIFAR10':

names.append('Самолет')

names.append('Авто')

names.append('Птица')

names.append('Кошка')

names.append('Олень')

names.append('Собака')

names.append('Лягушка')

names.append('Лошадь')

names.append('Судно')

names.append('Грузовик')

# m - число ошибочных предсказаний

m = 0

for i in range(n):

s_true = names[y[i]] # Истинное имя класса

s_pred = names[classes[i]] # Предсказанное моделью имя класса

if s_true != s_pred:

m += 1

if (m > nNotClassified): break

print(str(m) + '. i = ' + str(i) + '. На самом деле: ' + s_true + '. Прогноз: ' + s_pred)

Оценку обученной модели НС можно выполнить, применив метод evaluate:

# Оценка модели НС на тестовых данных

score = model.evaluate(X_test, y_test, verbose = 0)

# Вывод потерь и точности

print('Потери при тестировании: ', score[0])

print('Точность при тестировании:', score[1])

Введем следующие понятия:

<имя модели>_<номер обучения> (<функция потерь>, <критерий обучения> = <значение>, <эпоха>)

Например: c1_2(msle, acc = 99.83, 44).Примеры имен файлов с историей обучения:

В имени файла присутствуют имена набора данных, функции потерь, метода оптимизации и модели НС.

Файлы содержат вычисляемые после завершения каждой эпохи обучения значения следующих показателей:

Несколько строк из истории обучения c1(kld) приведены в табл. 6.

Таблица 6. Фрагмент истории обучения c1(kld)

| Эпоха | acc | loss | val_acc | val_loss |

|---|---|---|---|---|

| 46 | 0.99935 | 0.002294893305490647 | 0.9944 | 0.026391212741745676 |

| 47 | 0.9992166666666666 | 0.002841588792166052 | 0.9937 | 0.03381528404881883 |

| 48 | 0.9991666666348775 | 0.0034450070487480845 | 0.9937 | 0.03047861402691924 |

| 49 | 0.9987166666666667 | 0.004307920383231249 | 0.993 | 0.03465996994199886 |

| 50 | 0.9990166666666667 | 0.003380889197861931 | 0.9941 | 0.02796838024803625 |

| 51 | 0.9993 | 0.0027801058267907745 | 0.9941 | 0.028028475116779646 |

| 52 | 0.999 | 0.0033844195757255268 | 0.994 | 0.029609011523109803 |

| 53 | 0.9987666666666667 | 0.0038471691451656322 | 0.9937 | 0.03257301945153831 |

| 54 | 0.9987833333333334 | 0.0041574788408806854 | 0.9932 | 0.033359301897392495 |

| 55 | 0.999 | 0.0031364899551806352 | 0.9932 | 0.03427551583018867 |

Показатели acc, loss, val_acc и val_loss можно использовать для оценки качества обучения модели НС и выбора решения.

Введем еще один показатель:

corr_img – суммарное число правильно классифицированных изображений на обучающей и тестовых выборках.

Замечание. При выводе результатов для наглядности вместо corr_img используется значение err_img – суммарное число ошибочно классифицированных изображений на обучающих и проверочных данных:

err_img = all_img – corr_img,

где all_img – число изображений в наборе данных.

В дальнейшем показатели acc, loss, val_acc, val_loss и corr_img (err_img) будем называть критериями обучения.

В некоторых случая в истории обучения имеется эпоха, после которой acc и val_acc имеют (по сравнению с другими эпохами) максимальное значение, а loss, val_loss и err_img – минимальное.

Пример: модель c1(msle) после 44-й эпохи на MNIST:

acc = 99.845%; loss = 0.000133; val_acc = 99.52%; val_loss = 0.000416; err_img = 142.

В других эпохах обучения этой модели критерии обучения хуже.

Однако в большинстве случаев критерии обучения имеют наилучшие значения в разных эпохах; пример приведен в табл. 7.

Таблица 7. Лучшие эпохи (на MNIST) модели c17(sссe)

| Эпоха | acc, % | loss | val_acc, % | val_loss | err_img |

|---|---|---|---|---|---|

| 6 | 99.427 | 99.31 | 0.017919 | 0.024047 | 413 |

| 46 | 99.958 | 99.34 | 0.001229 | 0.033355 | 91 |

| 53 | 99.965 | 99.39 | 0.001319 | 0.033159 | 82 |

| 54 | 99.933 | 99.51 | 0.002135 | 0.032404 | 89 |

Замечание. Лучшие значения критериев обучения модели c17(sссe) в приведенной выше табл. 7 указаны полужирным шрифтом.

Таким образом, если лучшие значения критериев получены в разных эпохах, возникает задача выбора лучшего решения.

Нередко результаты обучения оцениваются по val_acc или по ошибке, равной 100 – val_acc (см., например, [7, 8]).

Такая оценка не дает полного представления о качестве обучения. Например, на MNIST максимум val_acc моделей c5(sh), c5(cce), c5(kld) и c5(pss) одинаков (val_acc = 99.4), однако значения acc и, следовательно, err_img различны (табл. 8):

Таблица 8. Сравнение решений с одинаковым val_acc

| Модель | val_acc, % | acc, % | err_img |

|---|---|---|---|

| c5(sh) | 99.4 | 99.876667 | 114 |

| c5(cce) | 99.4 | 99.673333 | 236 |

| c5(kld) | 99.4 | 99.89333 | 104 |

| c5(pss) | 99.4 | 99.955 | 67 |

Учитывая эту информацию, лучшим следует признать решение c5(pss).

Замечание 1. При обучении минимизируется значение функции потерь (loss) на обучающих данных. Однако этот показатель, как следует из [7, 8], редко применяется при выборе решения.

В табл. 9 показано, насколько серьезно решения, выбранные по критериям acc, val_acc и err_img, отличаются по потерям от решения с наименьшими потерями (берутся потери на обучающей выборке).

Таблица 9. Среднее относительное отклонение по потерям между лучшими решениями и решениями с наименьшими потерями

| Критерий | Отклонение, % | |||||

|---|---|---|---|---|---|---|

| Лучшие решения всего СО | Лучшие решения каждой модели СО | |||||

| MNIST | EMNIST | CIFAR-10 | MNIST | EMNIST | CIFAR-10 | |

| acc | 1.24 | 0.42 | 0.0 | 2.95 | 0.36 | 0.2 |

| val_acc | 31.66 | 18.28 | 2.82 | 38.18 | 57.27 | 4.1 |

| err_img | 0.15 | 1.22 | 0.0 | 7.54 | 0.77 | 0.36 |

Заполнение табл. 9 выполнено по следующему алгоритму:

Входные данные. Имя набора данных, критерий (acc, val_acc или err_img), список и истории обучения НС выбранного набора данных.

Выходные данные. loss_dif – среднее относительное отклонение (в %) по потерям между лучшими решениями и решениями с наименьшими потерями.

Измерение значения критерия – это обучение НС и последующая оценка обученной модели с целью вычисления значений критериев, которые и являются результатами измерений.

При работе с Keras при повторном обучении модели НС с неизмененными значениями параметров новое решение, если не принять специальных мер, как правило, отличается от прежнего. Примеры таких расхождений представлены в табл. 10, также такие примеры имеются и в прил. 1

Таблица 10. Результаты повторных обучений моделей НС

| Функция потерь | Номер обучения | Описание решения | ||||||

|---|---|---|---|---|---|---|---|---|

| Эпоха | val_acc | Δval_acc | acc | Δacc | err_img | Δerr_img | ||

| MNIST: модель 2c12 | ||||||||

| mse | 1 | 43 | 99.60 | 0.02 | 99.86 | 0.005 | 124 | 1 |

| 2 | 42 | 99.56 | 99.87 | 122 | ||||

| 3 | 78 | 99.57 | - | - | ||||

| mae | 1 | 53 | 99.50 | 0.025 | 99.67 | 0.015 | 238 | 16.5 |

| 2 | 45 | 99.45 | 99.64 | 271 | ||||

| 3 | 64 | 99.47 | - | - | ||||

| mape | 1 | 51 | 99.53 | 0.005 | 99.63 | 0.005 | 269 | 3 |

| 2 | 47 | 99.53 | 99.64 | 263 | ||||

| 3 | 35 | 99.52 | - | - | ||||

| msle | 1 | 74 | 99.57 | 0.025 | 99.90 | 0.02 | 103 | 15 |

| 2 | 46 | 99.57 | 99.85 | 133 | ||||

| 3 | 77 | 99.52 | - | - | ||||

| sh | 1 | 42 | 99.51 | 0.01 | 99.85 | 0 | 139 | 1 |

| 2 | 45 | 99.53 | 99.85 | 137 | ||||

| 3 | 99 | 99.51 | - | - | ||||

| h | 1 | 55 | 99.50 | 0.005 | 99.67 | 0.01 | 248 | 6 |

| 2 | 49 | 99.50 | 99.65 | 260 | ||||

| 3 | 88 | 99.51 | - | - | ||||

| ch | 1 | 40 | 99.45 | 0.01 | 99.59 | 0.03 | 301 | 17.5 |

| 2 | 46 | 99.47 | 99.65 | 266 | ||||

| 3 | 62 | 99.46 | - | - | ||||

| lc | 1 | 51 | 99.55 | 0.025 | 99.87 | 0.01 | 123 | 3.5 |

| 2 | 64 | 99.53 | 99.89 | 116 | ||||

| 3 | 117 | 99.58 | - | - | ||||

| cce | 1 | 31 | 99.55 | 0.005 | 99.8 | 0.045 | 165 | 26.5 |

| 2 | 56 | 99.54 | 99.89 | 112 | ||||

| 3 | 117 | 99.55 | - | - | ||||

| scce | 1 | 33 | 99.57 | 0.01 | 99.76 | 0.005 | 184 | 0.5 |

| 2 | 34 | 99.55 | 99.77 | 183 | ||||

| 3 | 58 | 99.56 | - | - | ||||

| bce | 1 | 52 | 99.57 | 0.025 | 99.86 | 0.015 | 127 | 13.5 |

| 2 | 52 | 99.52 | 99.83 | 154 | ||||

| 3 | 113 | 99.55 | - | - | ||||

| kld | 1 | 45 | 99.53 | 0.015 | 99.84 | 0.02 | 143 | 13.5 |

| 2 | 41 | 99.56 | 99.88 | 116 | ||||

| 3 | 36 | 99.56 | - | - | ||||

| pss | 1 | 53 | 99.52 | 0.05 | 99.85 | 0.02 | 138 | 15.5 |

| 2 | 39 | 99.45 | 99.81 | 169 | ||||

| 3 | 68 | 99.55 | - | - | ||||

| cp | 1 | 41 | 99.51 | 0.025 | 99.85 | 0.035 | 139 | 23.5 |

| 2 | 62 | 99.56 | 99.92 | 92 | ||||

| 3 | 107 | 99.52 | - | - | ||||

| ck | 1 | 64 | 99.53 | 0.025 | 99.9 | 0.025 | 107 | 10.5 |

| 2 | 42 | 99.58 | 99.84 | 138 | ||||

| 3 | 98 | 99.56 | - | - | ||||

| mk | 1 | 37 | 99.53 | 0.04 | 99.82 | 0.02 | 155 | 11 |

| 2 | 43 | 99.51 | 99.86 | 133 | ||||

| 3 | 68 | 99.59 | - | - | ||||

| EMNIST: модель 2c28 | ||||||||

| mse | 1 | 33 | 94.86 | 0.03 | 96.54 | 0.081 | 5387 | 404.5 |

| 2 | 53 | 94.91 | 97.18 | 4578 | ||||

| 3 | 31 | 94.92 | - | - | ||||

| mae | 1 | 54 | 91.05 | 1.345 | 90.74 | 1.38 | 13418 | 1877 |

| 2 | 52 | 93.74 | 93.3 | 9664 | ||||

| 3 | 52 | 93.56 | - | - | ||||

| mape | 1 | 32 | 92.91 | 0.07 | 92.79 | 0.34 | 10336 | 357.5 |

| 2 | 50 | 92.77 | 92.35 | 11051 | ||||

| 3 | 45 | 92.89 | - | - | ||||

| msle | 1 | 46 | 94.91 | 0.025 | 97.14 | 0.06 | 4628 | 74 |

| 2 | 53 | 94.90 | 97.26 | 4480 | ||||

| 3 | 44 | 94.95 | - | - | ||||

| sh | 1 | 64 | 94.86 | 0.22 | 96.71 | 0.175 | 4052 | 783 |

| 2 | 53 | 94.83 | 96.36 | 5618 | ||||

| 3 | 40 | 94.42 | - | - | ||||

| h | 1 | 70 | 92.69 | 0.93 | 92.16 | 0.84 | 11304 | 1183 |

| 2 | 28 | 91.40 | 90.48 | 13670 | ||||

| 3 | 25 | 93.36 | - | - | ||||

| ch | 1 | 40 | 94.14 | 0.08 | 93.99 | 0.045 | 8719 | 61 |

| 2 | 32 | 94.19 | 94.08 | 8597 | ||||

| 3 | 27 | 94.03 | - | - | ||||

| lc | 1 | 94 | 94.94 | 0.045 | 97.41 | 0.08 | 4285 | 90.5 |

| 2 | 61 | 95.03 | 97.25 | 4466 | ||||

| 3 | 42 | 94.97 | - | - | ||||

| cce | 1 | 74 | 94.76 | 0.08 | 97.17 | 0.045 | 4622 | 44.5 |

| 2 | 64 | 94.87 | 97.08 | 4711 | ||||

| 3 | 83 | 94.92 | - | - | ||||

| scce | 1 | 63 | 94.84 | 0.055 | 97.15 | 0.205 | 4630 | 252.5 |

| 2 | 107 | 94.81 | 97.56 | 4125 | ||||

| 3 | 76 | 94.92 | - | - | ||||

| bce | 1 | 53 | 94.80 | 0.045 | 97.7 | 0.275 | 3952 | 336 |

| 2 | 90 | 94.87 | 97.15 | 4624 | ||||

| 3 | 54 | 94.89 | - | - | ||||

| kld | 1 | 59 | 94.81 | 0.04 | 96.93 | 0.04 | 4911 | 52 |

| 2 | 59 | 94.83 | 97.01 | 4807 | ||||

| 3 | 52 | 94.89 | - | - | ||||

| pss | 1 | 69 | 94.92 | 0.02 | 97.18 | 0.18 | 4582 | 224.5 |

| 2 | 104 | 94.89 | 97.54 | 4133 | ||||

| 3 | 98 | 94.93 | - | - | ||||

| cp | 1 | 64 | 94.82 | 0.06 | 97.46 | 0.105 | 4247 | 137 |

| 2 | 74 | 94.88 | 97.67 | 3973 | ||||

| 3 | 83 | 94.94 | - | - | ||||

| ck | 1 | 87 | 94.87 | 0.01 | 97.32 | 0.19 | 4412 | 238 |

| 2 | 64 | 94.86 | 96.94 | 4888 | ||||

| 3 | 105 | 94.88 | - | - | ||||

| mk | 1 | 64 | 94.85 | 0.01 | 97.34 | 0.075 | 4391 | 95.5 |

| 2 | 63 | 94.83 | 97.19 | 4582 | ||||

| 3 | 50 | 94.84 | - | - | ||||

| CIFAR-10: модель c34 | ||||||||

| mse | 1 | 99 | 84.48 | 0.175 | - | - | - | - |

| 2 | 114 | 84.13 | - | - | ||||

| mae | 1 | 104 | 84.13 | 0.09 | - | - | - | - |

| 2 | 108 | 84.31 | - | - | ||||

| mape | 1 | 111 | 84.31 | 0.04 | - | - | - | - |

| 2 | 139 | 84.39 | - | - | ||||

| msle | 1 | 115 | 84.31 | 0.14 | - | - | - | - |

| 2 | 139 | 84.59 | - | - | ||||

| sh | 1 | 110 | 84.67 | 0.13 | - | - | - | - |

| 2 | 169 | 84.41 | - | - | ||||

| h | 1 | 172 | 84.32 | 0.215 | - | - | - | - |

| 2 | 140 | 84.75 | - | - | ||||

| ch | 1 | 102 | 84.92 | 0.175 | - | - | - | - |

| 2 | 151 | 84.57 | - | - | ||||

| lc | 1 | 148 | 84.62 | 0.175 | - | - | - | - |

| 2 | 161 | 84.52 | - | - | ||||

| cce | 1 | 161 | 84.59 | 0.085 | - | - | - | - |

| 2 | 170 | 84.76 | - | - | ||||

| scce | 1 | 118 | 84.40 | 0.01 | - | - | - | - |

| 2 | 180 | 84.38 | - | - | ||||

| bce | 1 | 167 | 84.96 | 0.175 | - | - | - | - |

| 2 | 157 | 85.31 | - | - | ||||

| kld | 1 | 121 | 84.56 | 0.21 | - | - | - | - |

| 2 | 169 | 84.98 | - | - | ||||

| pss | 1 | 100 | 84.57 | 0.035 | - | - | - | - |

| 2 | 103 | 84.50 | - | - | ||||

| cp | 1 | 118 | 84.48 | 0.045 | - | - | - | - |

| 2 | 150 | 84.39 | - | - | ||||

| ck | 1 | 80 | 84.64 | 0.095 | - | - | - | - |

| 2 | 158 | 84.83 | - | - | ||||

| mk | 1 | 80 | 84.65 | 0.11 | - | - | - | - |

| 2 | 173 | 84.87 | - | - | ||||

| CIFAR-10: модель ResNet20v1 | ||||||||

| mse | 1 | 139 | 90.08 | 0.17 | - | - | - | - |

| 2 | 158 | 80.42 | - | - | ||||

| mae | 1 | 159 | 85.09 | 10.83 | - | - | - | - |

| 2 | 196 | 67.43 | - | - | ||||

| mape | 1 | 132 | 69.20 | 5.52 | - | - | - | - |

| 2 | 151 | 80.24 | - | - | ||||

| msle | 1 | 188 | 89.11 | 0.39 | - | - | - | - |

| 2 | 160 | 89.89 | - | - | ||||

| sh | 1 | 167 | 90.14 | 0.26 | - | - | - | - |

| 2 | 186 | 89.62 | - | - | ||||

| h | 1 | 160 | 69.06 | 7.50 | - | - | - | - |

| 2 | 155 | 84.06 | - | - | ||||

| ch | 1 | 148 | 88.10 | 0.74 | - | - | - | - |

| 2 | 187 | 89.58 | - | - | ||||

| lc | 1 | 157 | 89.15 | 0.175 | - | - | - | - |

| 2 | 137 | 88.80 | - | - | ||||

| cce | 1 | 173 | 90.70 | 0.215 | - | - | - | - |

| 2 | 132 | 90.88 | - | - | ||||

| 3 | 145 | 90.45 | - | - | ||||

| scce | 1 | 154 | 90.66 | 0.245 | - | - | - | - |

| 2 | 155 | 90.98 | - | - | ||||

| 3 | 154 | 90.49 | - | - | ||||

| bce | 1 | 157 | 91.30 | 0.22 | - | - | - | - |

| 2 | 134 | 91.05 | - | - | ||||

| 3 | 150 | 91.49 | - | - | ||||

| kld | 1 | 138 | 91.10 | 0.25 | - | - | - | - |

| 2 | 187 | 90.81 | - | - | ||||

| 3 | 125 | 90.60 | - | - | ||||

| pss | 1 | 181 | 91.15 | 0.235 | - | - | - | - |

| 2 | 156 | 91.62 | - | - | ||||

| 3 | 126 | 91.41 | - | - | ||||

| 4 | 143 | 91.37 | - | - | ||||

| cp | 1 | 135 | 90.72 | 0.38 | - | - | - | - |

| 2 | 151 | 91.35 | - | - | ||||

| 3 | 166 | 90.59 | - | - | ||||

| 4 | 142 | 90.78 | - | - | ||||

| ck | 1 | 137 | 90.23 | 0.08 | - | - | - | - |

| 2 | 183 | 90.39 | - | - | ||||

| mk | 1 | 191 | 90.59 | 0.175 | - | - | - | - |

| 2 | 104 | 90.24 | - | - | ||||

В нашем случае измерение – это обучение НС и последующие вычисления значений критериев.

Погрешность измерений вычислена по следующей формуле:

Δcrit = (critmax – critmin) / 2,

Замечание 1. В приведенной выше таблице значения val_acc и acc берутся из файлов историй обучения. В файлах, хранящих acc, значения меньше, чем значения acc, полученные после оценки (evaluate) обученной модели НС или выполнения прогноза (prerdict). Например, для модели 2c28(lc) в файле acc_EMNIST_lc_Adam_2c28.txt после эпохи 61 имеем:

acc = 97.25%

После этой эпохи веса модели сохранены в файле weights_EMNIST_lc_Adam_2c28.61-0.95.hdf5 (val_acc после этой эпохи равен 95.03%).

После загрузки весов и выполнения оценки модели на обучающих данных имеем:

acc = 98.12%

То есть для этой модели err_img = 1052, а не 4466, как указано в табл. 9.

Такое расхождение объясняется тем, что при обучении берутся текущие значения acc, а при оценке класс определяется по наибольшему значению в выходном векторе. Например, текущий выход (случай двух классов) для объекта второго класса – это [0.2, 0.8], то есть точность 80%. Но при прогнозировании на обученной модели этот по этому вектору классифицируемый объект будет отнесен ко второму классу, то есть так же, как и при выходе [0.0, 1.0] (точность классификации 100%).

Замечание 2. Для функции потерь binary crossentropy в случае метрики 'accuracy' имеем завышенные значения точности.

Например, после 73-й эпохи обучения модели c7(bce) имеем на MNIST (эпоха 73 является лучшей по критерию val_acc):

val_acc = 99.89%

Однако после загрузки весов этой модели и выполнения evaluate (или predict) получим:

val_acc = 99.44%

Чтобы получить реальную точность, с binary crossentropy (lossFunNum == 11) используется вдобавок метрика categorical_accuracy:

metrics = ['accuracy', keras.metrics.categorical_accuracy] if lossFunNum == 11 else ['accuracy']

Замечание 3. В [9] погрешность измерений val_acc на EMNIST указывается равной ±0.12%.

Значение погрешности измерений val_acc может быть употреблено для поиска одинаково эффективных функций потерь: ФП одинаково эффективны, если значения val_acc, полученные в результате применения этих ФП, отличаются на величину, не превышающую погрешности измерения val_acc.

При поиске эффективных по val_acc ФП следует пользоваться погрешностью, найденной для ФП с большими значениями val_acc.

Используем для расчета средней величины погрешности следующие данные:

Таким образом, в задаче поиска эффективных ФП можно сделать следующие оценки погрешности измерений val_acc:

По мере накопления данных эти оценки могут корректироваться.

Воспроизведение результатов эпизода обучения обеспечивает следующий код [10], который должен быть исполнен до начала создания НС и ее обучения:

# Флаг задания режима воспроизведения результатов

repeat_results = False # True

seedVal = 348

import numpy as np

np.random.seed(seedVal) # Задание затравки датчика случайных чисел

#

if repeat_results:

print('Режим воспроизведения (повторяемости) результатов')

import random as rn

import tensorflow as tf

import os

from keras import backend as K

# Код, необходимый для воспроизведения результата

os.environ['PYTHONHASHSEED'] = '0'

rn.seed(seedVal)

tf.set_random_seed(seedVal)

session_conf = tf.ConfigProto(intra_op_parallelism_threads = 1,

inter_op_parallelism_threads = 1)

sess = tf.Session(graph = tf.get_default_graph(), config = session_conf)

K.set_session(sess)

В этом коде фиксируются затравки датчиков случайных чисел, значение системной переменной PYTHONHASHSEED и устанавливается в сессии tensorFlow однопоточность.

Обработка историй обучений позволяет:

После завершения эпизода история обучения и веса обученной модели НС сохраняются в папку, имя которой согласуется с именем модели НС. Так, истории обучения и веса модели c1 будут записаны в папку w_1, с2 – в папку w_2 и так далее.

Лучшее решение ищется по критерию err_img, val_acc или acc.

При поиске просматриваются все файлы с историями обучения и в результате определяются модель НС и функция потерь, обеспечившие лучшее значение выбранного критерия обучения, а также эпоха, после завершения которой это значение было получено.

Дополнительно для этой модели выводятся сведения об эпохах с наименьшими потерями loss и val_loss, а также сведения об эпохах с наилучшими значениями двух других критериев обучения.

Результаты поиска лучших решений по всем наборам данных и историям обучения приведены в табл. 11.

Таблица 11. Лучшие решения

| Лучшее решение | Критерий поиска и другие критерии | Описание эпохи | |||||

|---|---|---|---|---|---|---|---|

| № | acc | val_acc | loss | val_loss | err_img | ||

| MNIST | |||||||

| c6(kld, err_img = 56, 61) | Эпоха лучшего решения по err_img | 61 | 99.99833 | 99.45 | 0.000269 | 0.037857 | 56 |

| Эпоха наибольшей точности acc | то же | ||||||

| Эпоха наибольшей точности val_acc | то же | ||||||

| Эпоха наименьших loss-потерь | 120 | 99.99833 | 99.42 | 0.000269 | 0.04809 | 59 | |

| Эпоха наименьших val_loss-потерь | 6 | 99.31 | 99.19 | 0.020668 | 0.024443 | 495 | |

| 2c12_2(mse, val_acc = 99.6, 43) | Эпоха лучшего решения по val_acc | 43 | 99.85833 | 99.6 | 0.00028 | 0.000721 | 125 |

| Эпоха наибольшей точности acc | 61 | 99.92833 | 99.48 | 0.000197 | 0.000913 | 96 | |

| Эпоха наименьших loss-потерь | 58 | 99.91167 | 99.54 | 0.000187 | 0.000887 | 99 | |

| Эпоха наименьших val_loss-потерь | 43 | 99.85833 | 99.6 | 0.00028 | 0.000721 | 125 | |

| Эпоха с наименьшим err_img | 65 | 99.91833 | 99.57 | 0.000233 | 0.000725 | 92 | |

| c6(kld, acc = 99.99833, 61) | Лучшие решения по acc и err_img совпадают | ||||||

| EMNIST | |||||||

| c3(pss, err_img = 1555, 71) | Эпоха лучшего решения по err_img | 71 | 99.85176 | 93.41 | 0.038778 | 0.05943 | 1555 |

| Эпоха наибольшей точности acc | то же | ||||||

| Эпоха наибольшей точности val_acc | 14 | 97.74359 | 93.95 | 0.040561 | 0.048266 | 4075 | |

| Эпоха наименьших loss-потерь | 62 | 99.81971 | 93.56 | 0.038775 | 0.059236 | 1564 | |

| Эпоха наименьших val_loss-потерь | 6 | 95.81651 | 93.87 | 0.042742 | 0.045863 | 6497 | |

| 2c28(lc, val_acc = 95.03, 61) | Эпоха лучшего решения по val_acc | 61 | 97.2492 | 95.03 | 0.000786 | 0.001401 | 4466 |

| Эпоха наибольшей точности acc | 119 | 97.85657 | 94.59 | 0.000666 | 0.0015 | 3800 | |

| Эпоха наименьших loss-потерь | 115 | 97.83654 | 94.72 | 0.00065 | 0.001478 | 3798 | |

| Эпоха наименьших val_loss-потерь | 43 | 96.84615 | 94.88 | 0.00091 | 0.00138 | 5000 | |

| Эпоха с наименьшим err_img | 116 | 97.84776 | 94.79 | 0.000657 | 0.00146 | 3769 | |

| c3(pss, acc = 99.85176, 71) | Лучшие решения по acc и err_img совпадают | ||||||

| CIFAR-10 | |||||||

| res_net(kld, err_img = 1305, 177) | Эпоха лучшего решения по err_img | 177 | 99.2 | 90.95 | 0.1516 | 0.4993 | 1305 |

| Эпоха наибольшей точности acc | то же | ||||||

| Эпоха наибольшей точности val_acc | 137 | 99.08 | 91.10 | 0.1586 | 0.4948 | 1386 | |

| Эпоха наименьших loss-потерь | 197 | 99.18 | 90.98 | 0.1510 | 0.4995 | 1314 | |

| Эпоха наименьших val_loss-потерь | 83 | 96.57 | 90.35 | 0.2638 | 0.4779 | 2682 | |

| res_net(pss, val_acc = 0.9162, 155) | Эпоха лучшего решения по val_acc | 155 | 98.26 | 91.62 | 0.1172 | 0.1433 | 1706 |

| Эпоха наибольшей точности acc | 184 | 98.44 | 91.48 | 0.1167 | 0.1435 | 1634 | |

| Эпоха наименьших loss-потерь | 189 | 98.41 | 91.45 | 0.1167 | 0.1435 | 1649 | |

| Эпоха наименьших val_loss-потерь | 137 | 97.95 | 91.39 | 0.1183 | 0.1427 | 1885 | |

| Эпоха с наименьшим err_img | то же, что и для acc | ||||||

| c4(scce, acc = 0.99998, 63) | Эпоха лучшего решения по acc | 63 | 99.998 | 71.1 | 0.0004 | 2.504 | 2891 |

| Эпоха наибольшей точности val_acc | 71 | 99.998 | 71.23 | 0.001 | 2.159 | 2878 | |

| Эпоха наименьших loss-потерь | то же, что и для acc | ||||||

| Эпоха наименьших val_loss-потерь | 11 | 78.25 | 69.93 | 0.6171 | 0.8921 | 13881 | |

| Эпоха с наименьшим err_img | то же, что и для val_acc | ||||||

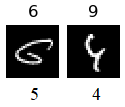

Замечание. Единственно ошибочно классифицируемое изображение из обучающей выборке MNIST моделью c6(kld) имеет индекс 59915 и в массиве меток y_train помечено как число 4:

y_train[59915] = 4

Это изображение (рис. 11) классифицируется моделью c6(kld) как число 7.

Рис. 11. Модель c6(kld) классифицирует это изображение как цифру 7

Поиск лучших решений по выбранному критерию выполняется в следующем порядке:

Входные данные:

Выходные данные: Список с описаниями лучших решений. Описание решения содержит:

Пример. Результат поиска лучшего решения на MNIST по corr_img:

Критерий: число ошибочно классифицированных изображений на обеих выборках

Число сканируемых директорий: 19

Набор данных: MNIST

Всего изображений: 70000

Лучшие решения:

1.

['val_acc_MNIST_kld_Adam_c6.txt', 'w_6', 'kld']

Всего эпох: 120

Описание эпох:

('Эпоха лучшего решения по err_img:', 60, 99.99833, 99.45, 0.000269, 0.037857, 56)

('Эпоха наибольшей точности acc:', 60, 99.99833, 99.45, 0.000269, 0.037857, 56)

('Эпоха наибольшей точности val_acc:', 60, 99.99833, 99.45, 0.000269, 0.037857, 56)

('Эпоха наименьших loss-потерь:', 119, 99.99833, 99.42, 0.000269, 0.04809, 59)

('Эпоха наименьших val_loss-потерь:', 5, 99.31, 99.19, 0.020668, 0.024443, 495)

Программа поиска лучших решений приведена в прил. 5.

По результатам обучения можно выявить решения, близкие к решениям, приведенным в табл. 11.

Примеры решений на MNIST, близких к решению c6(kld, err_img = 56, 61) приведены в табл. 12.

Таблица 12. Решение c6(kld, err_img = 56, 61) и близкие к нему решения на MNIST

| Решение | err_img | val_acc | acc |

|---|---|---|---|

| c6(kld, err_img = 56, 61) | 56 | 99.45 | 99.99833 |

| c6(cce, err_img = 57, 51) | 57 | 99.44 | 99.99833 |

| c6(ck, err_img = 57, 118) | 57 | 99.44 | 99.99833 |

| c9(kld, err_img = 57, 119) | 57 | 99.44 | 99.99833 |

| c9(pss, err_img = 57, 59) | 57 | 99.44 | 99.99833 |

| c9(scce, err_img = 59, 61) | 59 | 99.42 | 99.99833 |

| c4(cce, err_img = 60, 63) | 60 | 99.41 | 99.99833 |

| c4(ck, err_img = 60, 110) | 60 | 99.41 | 99.99833 |

Верхняя граница критерия err_img при составлении списка берется исходя из погрешности оценки результата обучения по этому показателю. Аналогичные списки можно составить и по критериям val_acc и acc.

Назовем решения, присутствующие в подобных списках, потенциально лучшими.

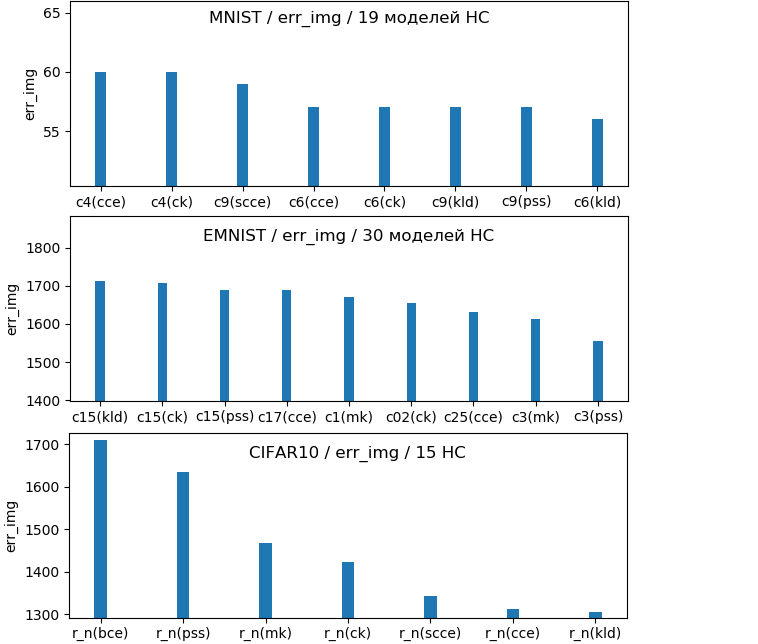

Диаграммы потенциально лучших решений по критерию err_img для разных наборов данных приведены на рис. 12.

Рис. 12. Потенциально лучшие решения по критерию err_img

Изображенные на рис. 12 диаграммы построены по приведенным в табл. 13 данным.

Таблица 13. Потенциально лучшие решения по критерию err_img| MNIST | EMNIST | CIFAR-10 | |||

|---|---|---|---|---|---|

| Решение | err_img | Решение | err_img | Решение | err_img |

| c4(cce, err_img = 60, 62) c4(ck, err_img = 60, 109) c9(scce, err_img = 59, 60) c6(cce, err_img = 57, 50) c6(ck, err_img = 57, 117) c9(kld, err_img = 57, 118) c9(pss, err_img = 57, 58) c6(kld, err_img = 56, 60) | 60 60 59 57 57 57 57 56 | c15(kld, err_img = 1712, 119) c15(ck, err_img = 1708, 108) c15(pss, err_img = 1690, 104) c17(cce, err_img = 1689, 117) c1(mk, err_img = 1671, 56) c02(ck, err_img = 1656, 59) c25(cce, err_img = 1632, 98) c3(mk, err_img = 1614, 68) c3(pss, err_img = 1555, 70) | 1712 1708 1690 1689 1671 1656 1632 1614 1555 | res_net(kld, err_img = 1305, 177) res_net(cce, err_img = 1312, 175) res_net(scce, err_img = 1343, 157) res_net(ck, err_img = 1424, 177) res_net(mk, err_img = 1468, 179) res_net(pss, err_img = 1634, 184) res_net(bce, err_img = 1709, 181) | 1305 1312 1343 1424 1468 1634 1709 |

Вывод диаграммы потенциально лучших решений выполняет процедура plotBestResultsDiag программы обработки историй обучения.

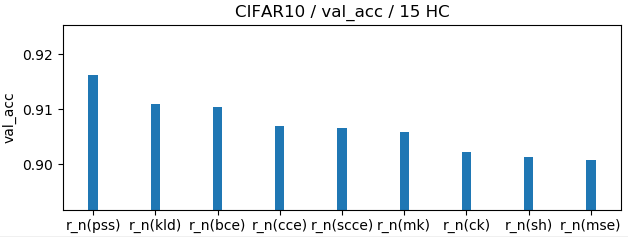

В табл. 14 показаны потенциально лучшие решения по критерию val_acc.

Таблица 14. Потенциально лучшие решения по критерию val_acc

| MNIST | EMNIST | CIFAR-10 | |||

|---|---|---|---|---|---|

| Решение | val_acc | Решение | val_acc | Решение | val_acc |

| 3c12(cce, val_acc = 0.9957, 83) 2c12(msle, val_acc = 0.9957, 73) 2c12(bce, val_acc = 0.9957, 52) 3c12(bce, val_acc = 0.9957, 54) 2c12(msle, val_acc = 0.9957, 45) 3c12(ck, val_acc = 0.9957, 38) 3c12(kld, val_acc = 0.9957, 34) 2c12(scce, val_acc = 0.9957, 32) 2c12(ck, val_acc = 0.9958, 62) 2c12(mse, val_acc = 0.996, 42) | 0.9957 0.9957 0.9957 0.9957 0.9957 0.9957 0.9957 0.9957 0.9958 0.9960 | 2c28(cce, val_acc = 0.94865, 63) 2c28(bce, val_acc = 0.94870, 90) 2c28(ck, val_acc = 0.94870, 86) 2c28(cp, val_acc = 0.94875, 73) 2c24(sh, val_acc = 0.94875, 73) 2c27(lc, val_acc = 0.94885, 49) 2c28(pss, val_acc = 0.94889, 103) 2c28(msle, val_acc = 0.94903, 52) 2c28(msle, val_acc = 0.94909, 73) 2c24(msle, val_acc = 0.94909, 28) 2c28(mse, val_acc = 0.94914, 52) 2c24(mk, val_acc = 0.94918, 85) 2c28(pss, val_acc = 0.94918, 68) 2c28(lc, val_acc = 0.94942, 93) 2c27(mse, val_acc = 0.94947, 42) 2c28(lc, val_acc = 0.95034, 60) | 0.94865 0.94870 0.94870 0.94875 0.94875 0.94885 0.94889 0.94903 0.94909 0.94909 0.94914 0.94918 0.94918 0.94942 0.94947 0.95034 | res_net(pss, val_acc = 0.9162, 155) res_net(kld, val_acc = 0.911, 137) res_net(bce, val_acc = 0.9105, 133) res_net(cce, val_acc = 0.907, 172) res_net(scce, val_acc = 0.9066, 153) res_net(mk, val_acc = 0.9059, 190) res_net(ck, val_acc = 0.9023, 136) res_net(sh, val_acc = 0.9014, 166) res_net(mse, val_acc = 0.9008, 138) | 0.9162 0.9110 0.9105 0.907 0.9066 0.9059 0.9023 0.9014 0.9008 |

Приведенные в табл. 13 решения получены с применением разных функций потерь. Все они могут быть отнесены к числу наиболее эффективных функций потерь.

Составим по табл. 13 для MNIST список функций потерь:

[ [kld, 2, 56.5], [cce, 2, 58.5], [ck, 2, 58.5], [pss, 1, 57], [scce, 1, 59] ].

Элемент списка записан по следующему шаблону:

[<ФП>, <число появлений ФП в СПЛР>, <усредненное значение критерия обучения>], (*)

где ФП – функция потерь;

СПЛР – список потенциально лучших решений.

Таким образом, для обучения на MNIST по критерию err_img могут быть рекомендованы следующие функции потерь: kld, cce, ck, pss и scce.

Составим по историям обучения списки эффективных функций потерь для всех наборов данных и всех критериев обучения, используя следующий алгоритм:

Входные данные: имя набора данных, имя критерия обучения, список директорий, хранящих истории обучения, погрешность оценки результатов обучения.

Функции потерь, выявленные по историям обучения моделей НС, приведены в табл. 15.

Таблица 15. Эффективные функции потерь

| Набор данных | Критерий | Нижняя граница критерия | Всего решений | [Функция потерь, число повторов, значение критерия] |

|---|---|---|---|---|

| MNIST | err_img | 60 | 22 | ['cce', 3, 55.9997] ['kld', 3, 55.9997] ['ck', 3, 57.9999] ['bce', 2, 49.5] ['pss', 2, 54.4995] ['scce', 2, 54.5] ['lc', 1, 48.0] ['mse', 1, 53.0] ['msle', 1, 55.0] ['h', 1, 56.0] ['mk', 1, 56.0] ['mape', 1, 57.0] ['sh', 1, 59.0] |

| val_acc | 99.57 | 28 | ['ck', 3, 99.59] ['kld', 3, 99.58] ['scce', 3, 99.58] ['cce', 3, 99.58] ['msle', 3, 99.57] ['bce', 2, 99.61] ['pss', 2, 99.6] ['mse', 2, 99.59] ['mape', 1, 99.64] ['sh', 1, 99.63] ['h', 1, 99.62] ['mk', 1, 99.62] ['lc', 1, 99.61] ['mae', 1, 99.6] ['ch', 1, 99.6] | |

| acc | 99.90 | 172 | ['ck', 18, 99.9585] ['cce', 18, 99.9577] ['scce', 18, 99.956] ['kld', 17, 99.9631] ['pss', 17, 99.9619] ['mk', 17, 99.9526] ['bce', 15, 99.9627] ['mse', 13, 99.9326] ['msle', 10, 99.9318] ['sh', 9, 99.9185] ['cp', 8, 99.9235] ['lc', 7, 99.9298] ['mape', 2, 99.9567] ['h', 1, 99.9717] ['mae', 1, 99.97] ['ch', 1, 99.9683] | |

| EMNIST | err_img | 1750 | 11 | ['mk', 3, 1666.3333] ['cce', 3, 1681.6667] ['pss', 2, 1622.5] ['ck', 1, 1708.0] ['kld', 1, 1712.0] ['scce', 1, 1718.0] |

| val_acc | 94.87 | 39 | ['lc', 5, 95.07] ['msle', 5, 95.06] ['mse', 4, 95.08] ['pss', 4, 95.03] ['mk', 3, 95.13] ['ck', 3, 95.05] ['scce', 2, 95.2] ['bce', 2, 95.18] ['kld', 2, 95.16] ['cce', 2, 95.13] ['sh', 2, 95.02] ['h', 1, 95.24] ['mae', 1, 95.21] ['ch', 1, 95.19] ['mape', 1, 95.13] ['cp', 1, 94.88] | |

| acc | 98.25 | 104 | ['mk', 11, 99.3056] ['cce', 10, 99.2482] ['kld', 10, 99.2074] ['mse', 9, 98.7293] ['lc', 9, 98.677] ['cp', 9, 98.5375] ['pss', 8, 99.4253] ['ck', 8, 99.3027] ['scce', 8, 99.1779] ['msle', 8, 98.7655] ['bce', 7, 98.9182] ['sh', 7, 98.7436] | |

| CIFAR-10 | err_img | 2000 | 7 | ['kld', 1, 1305] ['cce', 1, 1312] ['scce', 1, 1343] ['ck', 1, 1424] ['mk', 1, 1468] ['pss', 1, 1634] ['bce', 1, 1710] |

| val_acc | 90.00 | 9 | ['pss', 1, 91.62] ['kld', 1, 91.1] ['bce', 1, 91.05] ['cce', 1, 90.7] ['scce', 1, 90.66] ['mk', 1, 90.59] ['ck', 1, 90.23] ['sh', 1, 90.14] ['mse', 1, 90.08] | |

| acc | 97.00 | 101 | ['mk', 11, 98.5062] ['kld', 11, 98.4329] ['cce', 11, 98.4042] ['scce', 11, 98.3204] ['ck', 10, 98.4912] ['bce', 10, 98.3962] ['pss', 10, 98.2378] ['mse', 8, 97.895] ['msle', 7, 97.9791] ['lc', 7, 97.8137] ['cp', 3, 98.6267] ['sh', 2, 97.349] |

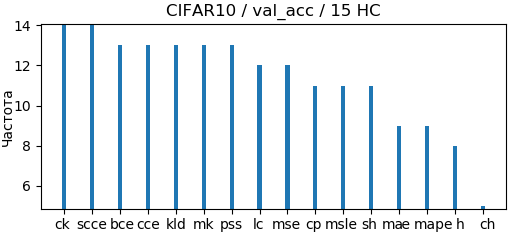

Диаграммы строятся по историям обучения после задания набора данных и вида критерия обучения.

Возможны три вида диаграмм:

Возможны три варианта построения диаграмм двух первых видов:

В первом случае определяется лучшее решений по всем моделям, а затем к нему добавляются решения, близкие по заданному критерию обучения; функции потерь, обеспечившие эти решения, считаются эффективными.

Во втором случае выполняется перебор моделей НС, определяется лучшее решение для текущей модели НС, далее к нему добавляются решения, близкие по заданному критерию обучения; функции потерь, обеспечившие эти решения добавляются в список эффективных функций потерь.

В третьем случае имеет смысл только средневзвешенная диаграмма, поскольку на частной для каждой функции будет получена одинаковая частота, равная числу используемых моделей НС.

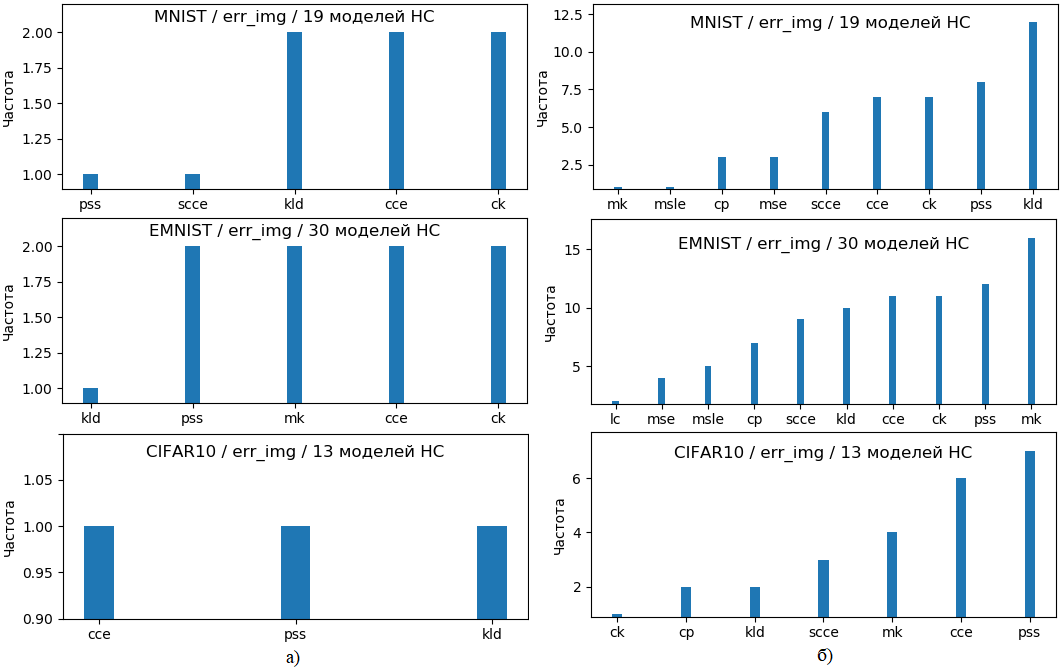

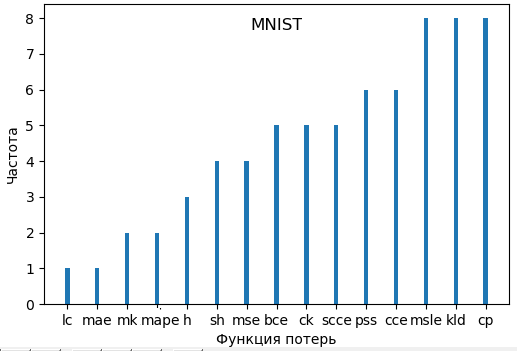

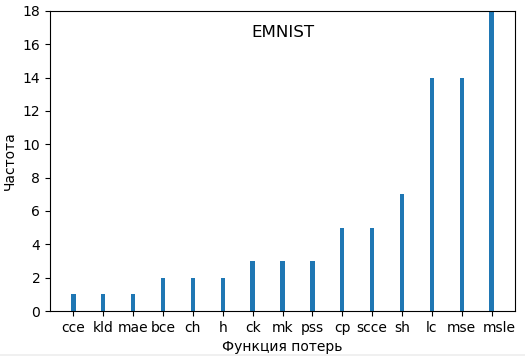

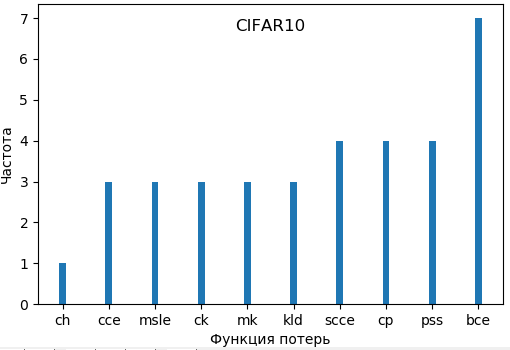

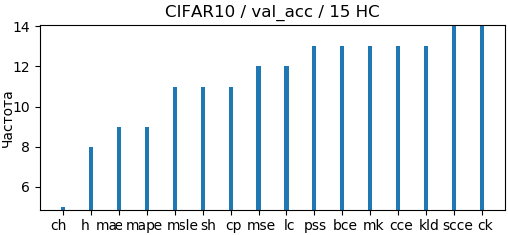

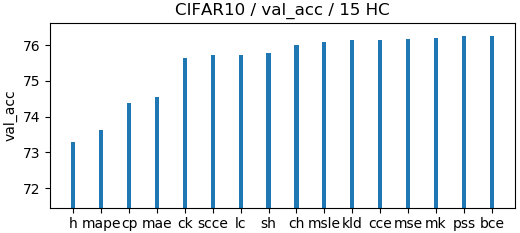

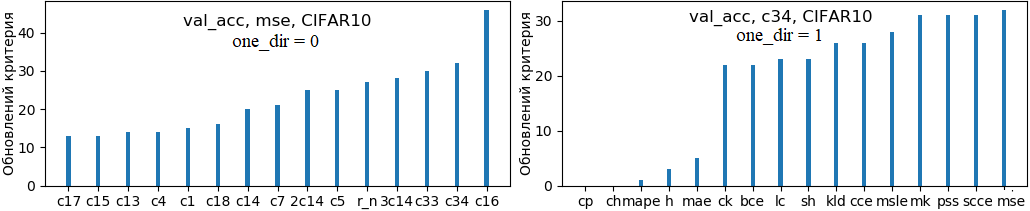

На рис. 13 показаны частотные диаграммы, отвечающие первым двум случаям; по оси абсцисс отложены имена функций потерь, а по оси ординат – частота появления функций в списке эффективных функций потерь, сформированном по историям обучения; функции упорядочены по возрастанию частоты.

Рис. 13. Частотные диаграммы эффективности функций потерь:

а – по потенциально лучшим решениям для всех моделей НС (mean_eff_all = False, one_dir = 0, showFreqDiag = True);

б – по потенциально лучшим решениям каждой модели НС (mean_eff_all = False, one_dir = 2, showFreqDiag = True)

Диаграммы, показанные на рис. 13, а, построены по данным, приведенным в табл. 16.

Таблица 16. Частота появления функций потерь в списке потенциально лучших решений для всех моделей НС

| MNIST | EMNIST | CIFAR-10 |

|---|---|---|

| ['kld', 2] ['cce', 2] ['ck', 2] ['pss', 1] ['scce', 1] | ['pss', 2] ['mk', 2] ['cce', 2] ['ck', 2] ['kld', 1] | ['kld', 1] ['cce', 1] ['scce', 1] ['ck', 1] ['mk', 1] ['pss', 1] ['bce', 1] |

Диаграммы, показанные на рис. 13, б, построены по данным, приведенным в табл. 17.

Таблица 17. Частота появления функций потерь в списке потенциально лучших решений для каждой модели НС

| MNIST | EMNIST | CIFAR-10 |

|---|---|---|

| ['bce', 21] ['cce', 21] ['ck', 21] ['kld', 21] ['mk', 21] ['pss', 21] ['scce', 21] ['lc', 20] ['mse', 20] ['msle', 20] ['sh', 20] ['cp', 19] ['ch', 17] ['h', 17] ['mae', 17] ['mape', 17] | ['ck', 31] ['cce', 30] ['kld', 30] ['mk', 30] ['pss', 30] ['scce', 29] ['msle', 28] ['bce', 27] ['lc', 27] ['mse', 27] ['sh', 26] ['cp', 23] ['ch', 2] ['h', 1] ['mae', 1] ['mape', 1] | ['bce', 14] ['cce', 14] ['scce', 14] ['ck', 13] ['mk', 13] ['msle', 13] ['kld', 12] ['lc', 12] ['mse', 12] ['pss', 12] ['cp', 10] ['sh', 10] ['mape', 5] ['ch', 3] ['h', 3] ['mae', 3] |

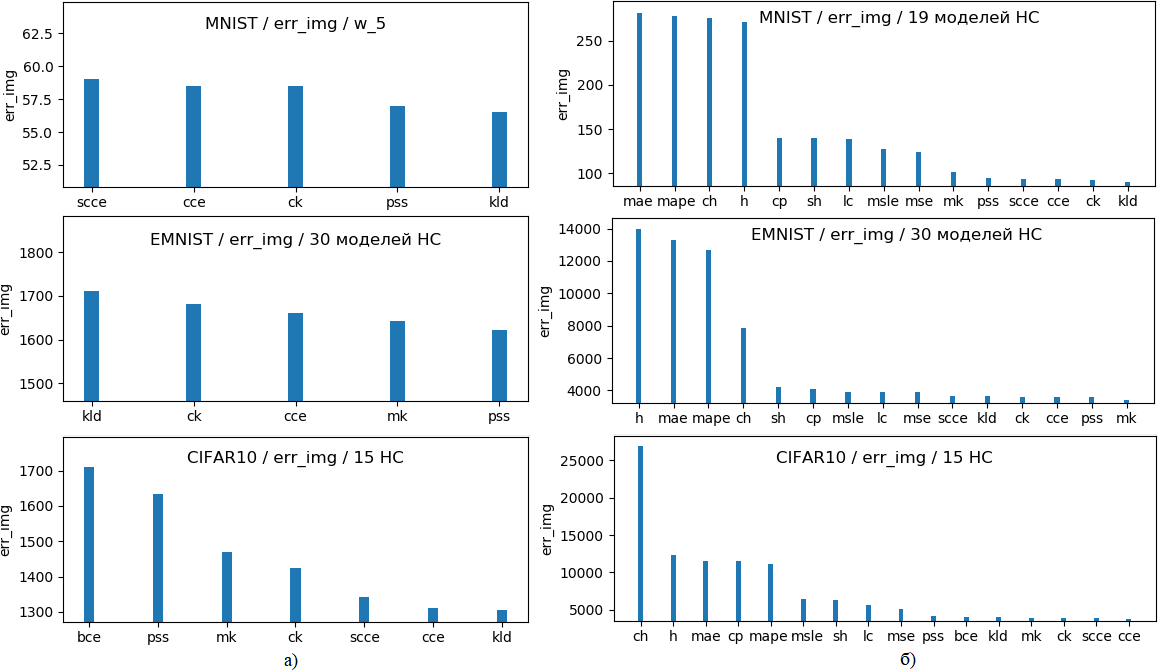

На рис. 14 показаны средневзвешенные диаграммы для решений, полученных на разных наборах данных; по оси абсцисс так же отложены имена функций потерь, а по оси ординат – значения критерия обучения, усредненные для лучших (рис. 14, а) и всех (рис. 14, б) решений.

Рис. 14. Средневзвешенные диаграммы эффективности функций потерь на всех моделях НС по критерию обучения err_img:

а – отобраны только лучшие решения (mean_eff_all = False, one_dir = 0);

б – взяты все решения (mean_eff_all = True, one_dir = 0)

Перед выводом диаграммы (рис. 14) данные сортируются по убыванию err_img.

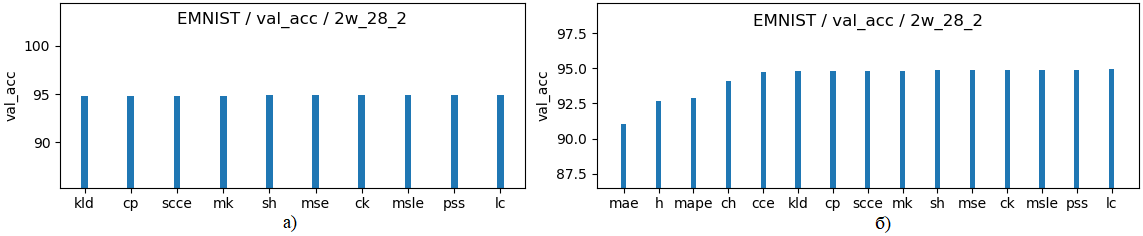

На диаграммах (рис. 15) показана эффективность функций потерь, примененных на EMNIST для модели 2c28, по критерию val_acc; по оси абсцисс отложены имена функций потерь, а по оси ординат – значения критерия обучения.

Рис. 15. Диаграмма эффективности функций потерь для 2c28 на EMNIST по критерию val_acc:

а – только лучшие решения;

б – все решения

Вывод диаграмм обеспечивает процедура plotDiags программы обработки историй обучения.

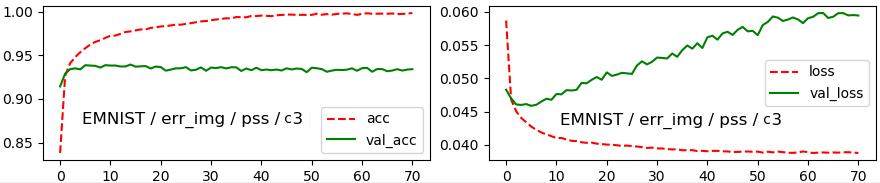

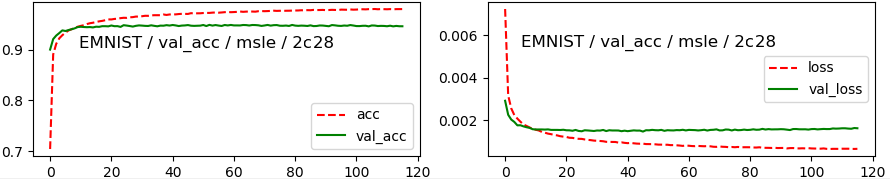

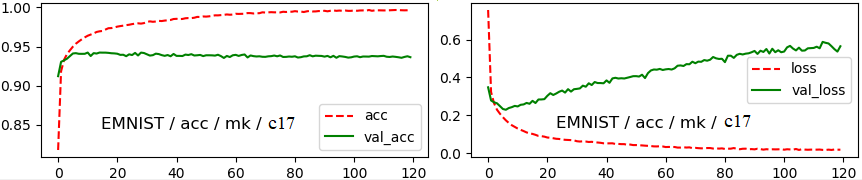

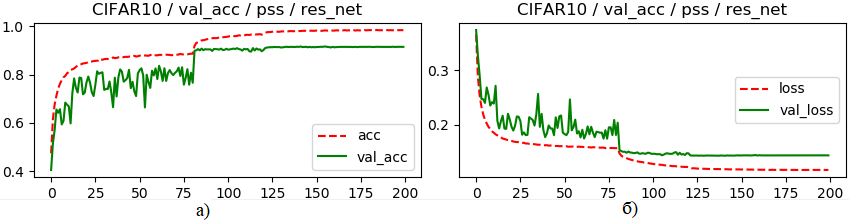

На рис. 16-18 показаны графики обучения (изменения точности и потерь) для лучших решений на EMNIST по критериям err_img, val_acc и acc.

По оси абсцисс отложены номера эпох, а по оси ординат – либо точность классификации, либо потери.

Лучшее решение выбрано после обучения 30 моделей. Каждая модель обучалась на EMNIST с применением 16-и функций потерь.

Рис. 16. График обучения лучшего решения по критерию err_img

Рис. 17. График обучения лучшего решения по критерию val_acc

Рис. 18. График обучения лучшего решения по критерию acc

Из приведенных графиков видно, что НС, выбранные по критериям err_img (рис. 16) и acc (рис. 18), являются переобученными (снижение потерь на обучающем множестве сопровождается ростом потерь на оценочном множестве). Устранение причин, вызывающих переобучение, приведет к росту качества обучения по всем трем используемым критериям.

Вывод графиков обучения выполняет следующая процедура:

def plot_hist(is_acc, sva, crit_list, pref_list, imgType, crit, d):

import matplotlib.pyplot as plt # Например, d = ' / '

# crit_list:

# [epoch_all, epoch, acc, loss, val_acc, val_loss, corr_img, fn, dr, fun, p]

bias = 7 if sva < 2 else 3 # sva = 1 (2) - Точность на тестовых (обучающих) данных

fn = crit_list[7]

dr = crit_list[8]

fun = crit_list[9]

p = crit_list[10]

base = fn[bias:]

ttl = imgType + d + crit + d + fun + d + dr

if is_acc:

ks = 0

lb = 'acc'

lb2 = 'val_acc'

loc = 'lower right'

else:

ks = 1

lb = 'loss'

lb2 = 'val_loss'

loc = 'center right'

acc_loss = readFile(p + pref_list[ks] + base)

val_acc_loss = readFile(p + pref_list[ks + 2] + base)

plt.figure(figsize = (5, 2))

plt.plot(acc_loss, color = 'r', label = lb, linestyle = '--')

plt.plot(val_acc_loss, color = 'g', label = lb2)

plt.title(ttl)

plt.legend(loc = loc)

plt.show()

Определяются следующие характеристики историй обучения:

Эти значения можно находить как для потенциально лучших решений по заданному критерия обучения, так и для выбранного решения.

Поиск выполняется в случае критерия val_acc или acc по истории обучения, отвечающей текущему решению. В случае критерия corr_img предварительно создается список, содержащий значения критерия для текущего решения.

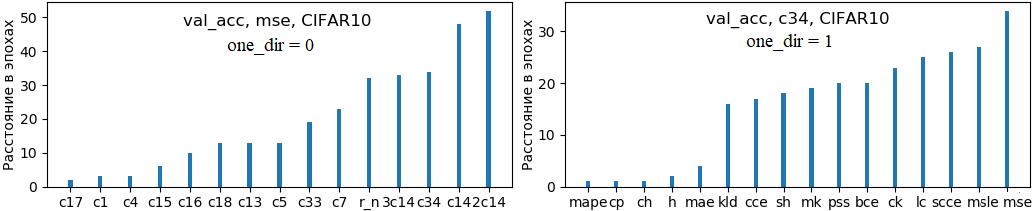

Сведения о наибольших расстояниях между эпохами двух последовательных обновлений максимума критерия обучения для различных наборов данных и критериев обучения приведены в табл. 18.

Таблица 18. Наибольшие расстояния между эпохами двух последовательных обновлений максимума критерия обучения

| Решение | Наибольшее расстояние | Номера эпох обновления максимума критерия | Значение критерия обучения в этих эпохах |

|---|---|---|---|

| MNIST | |||

| c6(ck, err_img = 57, 118) | 38 | 40 / 78 | 60 / 59 |

| 2c12_2(msle, val_acc = 99.57, 74) | 29 | 45 / 74 | 99.55 / 99.57 |

| c13(mk, acc = 99.967, 120) | 38 | 75 / 113 | 99.957 / 99.958 |

| EMNIST | |||

| c3(pss, err_img = 1555, 71) | 9 | 62 / 71 | 1564 / 1555 |

| 2c28(cp, val_acc = 94.875, 74) | 45 | 29 / 74 | 94.817 / 94.875 |

| c4(ck, acc = 99.681, 76) | 12 | 64 / 76 | 99.621 / 99.681 |

| CIFAR-10 | |||

| res_net(bce, err_img = 1710, 182) | 17 | 165 / 182 | 1741 / 1710 |

| res_net(bce, val_acc = 91.05, 134) | 48 | 33 / 81 | 84.27 / 84.35 |

| c1(mk, acc = 98.80, 100) | 18 | 82 / 100 | 98.77 / 98.80 |

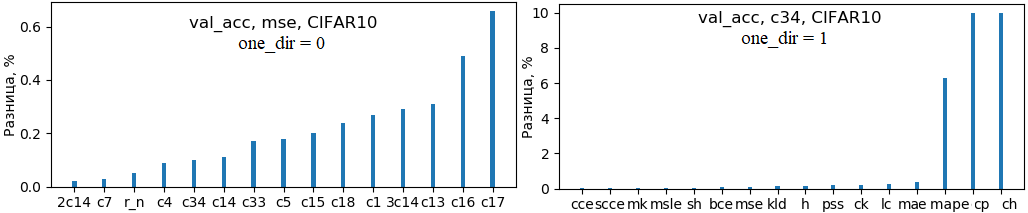

Сведения о наибольшей разнице между двумя последними обновлениями максимума критерия обучения для различных наборов данных и критериев обучения приведены в табл. 19.

Таблица 19. Наибольшие разницы между двумя последними обновлениями максимума критерия обучения

| Решение | Наибольшая разница | Номера эпох обновления максимума критерия | Значение критерия обучения в этих эпохах |

|---|---|---|---|

| MNIST | |||

| c9(sсce, err_img = 59, 118) | 11 | 29 / 31 | 70 / 59 |

| 2c12_2(mse, val_acc = 99.6, 43) | 0.09 | 37 / 43 | 99.51 / 99.6 |

| c4(scce, acc = 99.985, 25) | 0.077 | 23 / 25 | 99.908 / 99.985 |

| EMNIST | |||

| c15(pss, err_img = 1690, 105) | 109 | 104 / 105 | 1799 / 1690 |

| 2c24(msle, val_acc = 94.91, 29) | 0.226 | 25 / 29 | 94.68 / 94.91 |

| c1(mk, acc = 99.794, 57) | 0.1 | 51 / 57 | 99.694 / 99.794 |

| CIFAR-10 | |||

| res_net(scce, err_img = 1343, 158) | 42 | 153 / 158 | 1385 / 1343 |

| res_net(bce, val_acc = 91.05, 134) | 0.18 | 131 /134 | 90.87 / 91.05 |

| c4(ck, acc = 99.68, 34) | 0.552 | 33 / 34 | 99.132 / 99.68 |

Замечание. В случае corr_img выводится err_img = all_img – corr_img, где all_img – число изображений в наборе данных.

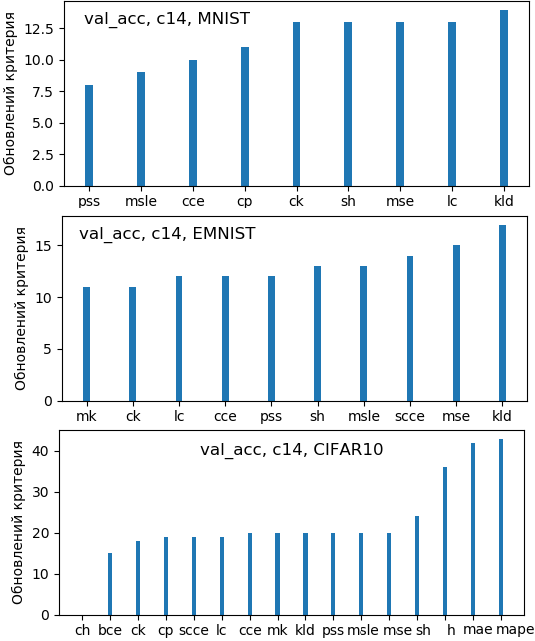

Число обновлений максимума критерия обучения определяется для потенциально лучших решений выбранной модели НС. Эта характеристика для модели c14 и критерия val_acc приведена в табл. 20.

Таблица 20. Число обновлений максимума val_acc при обучении модели c14

| Функция потерь | Число обновлений максимума val_acc | Всего эпох | val_acc, % |

|---|---|---|---|

| MNIST | |||

| pss | 8 | 120 | 99.49 |

| msle | 9 | - '' - | 99.51 |

| cce | 10 | - '' - | 99.50 |

| cp | 11 | - '' - | 99.52 |

| ck | 13 | - '' - | 99.51 |

| sh | 13 | - '' - | - '' - |

| mse | 13 | - '' - | 99.49 |

| lc | 13 | - '' - | - '' - |

| kld | 14 | - '' - | 99.51 |

| EMNIST | |||

| mk | 11 | 60 | 94.50 |

| ck | 11 | - '' - | 94.47 |

| lc | 12 | - '' - | 94.62 |

| cce | 12 | - '' - | 94.52 |

| pss | 12 | - '' - | 94.45 |

| sh | 13 | - '' - | 94.53 |

| msle | 13 | - '' - | 94.50 |

| scce | 14 | - '' - | 94.52 |

| mse | 15 | - '' - | 94.62 |

| kld | 17 | - '' - | 94.47 |

| CIFAR-10 | |||

| ch | 12 | 0 | 30.62 |

| bce | 120 | 15 | 73.56 |

| ck | 120 | 18 | 73.71 |

| cp | 120 | 19 | 73.34 |

| scce | 120 | 19 | 73.13 |

| lc | 120 | 20 | 72.40 |

| cce | 120 | 20 | 74.1 |

| mk | 120 | 20 | 73.88 |

| kld | 116 | 20 | 73.61 |

| pss | 120 | 20 | 73.57 |

| msle | 120 | 20 | 72.69 |

| sh | 120 | 24 | 72.68 |

| h | 120 | 36 | 72.03 |

| mae | 120 | 42 | 71.50 |

| mape | 120 | 43 | 71.92 |

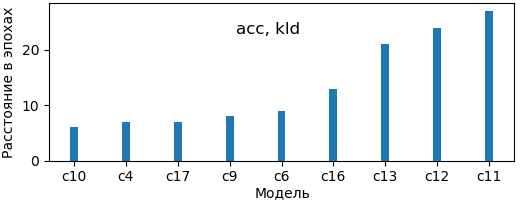

На рис. 19 показана диаграмма максимальных расстояний между эпохами двух последовательных обновления максимума критерия acc при обучении разных моделей на MNIST с функцией kld (как и ранее берутся потенциально лучшие решения).

Рис. 19. Максимальные расстояния между эпохами обновления максимума критерия acc (MNIST, лучшие решения)

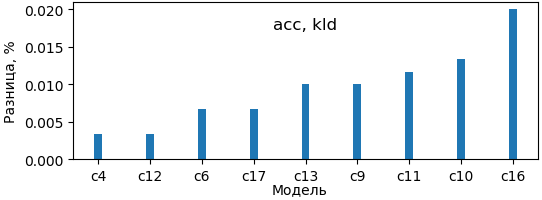

На рис. 20 приведена диаграмма максимальных разниц значений критерия acc двух последовательных обновления его максимума при обучении разных моделей на MNIST с функцией kld (как и ранее берутся потенциально лучшие решения).

Рис. 20. Разница между значениями критерия acc при последних обновлениях его максимума (MNIST, лучшие решения)

На рис. 21 приведены диаграммы числа обновлений максимума критерия val_acc, построенные по табл. 14.

Рис. 21. Число обновлений максимума критерия val_acc

Приведенные результаты позволяет получить процедура find_history_values программы обработки историй обучения.

Такие модели выявляются по историям обучения после задания набора данных, критерия обучения и коэффициента близости списков эффективных функций потерь

Порядок обработки данных по следующей схеме:

Два списка считаются близкими, если число n_eq одинаковых функций потерь в этих списках удовлетворяет следующему условию:

n_eq >= near * (len1 + len2) / 2,

где near – коэффициент близости списков;

len1, len2 – длины списков.

Результаты для различных наборов данных с критерием обучения err_img – число ошибочно классифицированных изображений:

MNIST. Всего моделей: 19. near = 0.85:

1

['w_6', 'w_4']

[['cce', 'ck', 'kld']]

[['cce', 'ck', 'kld']]

CR20-P-CR30-P-F-DR600 / 898'580

CR20-P-CR30-P-F-DR600-DL30 / 910'910

2

['w_9', 'w_1']

[['kld', 'pss', 'scce']]

[['kld', 'pss', 'scce']]

CR20-P-CR30-P-F-DR600-DL16 / 902'356

CR32-P-CR64-P-F-0.35-DR1024-0.2-DL30 / 3'276'724

3

['w_12', 'w_17']

[['cce']]

[['cce']]

CR20-P-CR30-P-F-0.25-DR600-0.2-DL16 / 902'356

CR32-P-CR64-P-F-0.25-DR800-DL30 / 2'567'316

4

['2w_12', '3w_12']

[['cp', 'mse']]

[['cp', 'mse']]

CR20-P-CR30-P-F-0.25-DR600-0.2-DL16 / 902'356 * 2

CR20-P-CR30-P-F-0.25-DR600-0.2-DL16 / 902'356 * 3

Список моделей, не имеющих моделей с близким списком эффективных функций потерь:

['w_5', 'w_7', 'w_8', 'w_11', '2w_12_2', 'w_13', 'w_14', 'w_10', 'w_15', 'w_16', 'w_18']

Длина списка: 11

Всего моделей: 19

EMNIST. Всего моделей: 30. near = 0.85:

1

['w_19', 'w_28']

[['kld', 'mk', 'scce']]

[['kld', 'mk', 'scce']]

CR10-P-CR15-P-F-0.25-DR300 / 231'211

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60-0.2 / 930'216

2

['w_9', 'w_24']

[['ck', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'mk', 'pss', 'scce']]

CR20-P-CR30-P-F-DR600-DL16 / 902'628

CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 / 949'026

3

['w_12', 'w_1']

[['mk']]

[['mk']]

CR20-P-CR30-P-F-0.25-DR600-0.2-DL16 / 902'628

CR32-P-CR64-P-F-0.35-DR1024-0.2-DL30 / 3'277'220

4

['2w_12', '3w_12']

[['cp', 'msle']]

[['cp', 'msle']]

CR20-P-CR30-P-F-0.25-DR600-0.2-DL16 / 902'628 * 2

CR20-P-CR30-P-F-0.25-DR600-0.2-DL16 / 902'628 * 3

5

['w_13', 'w_14']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

CR20-P-CR30-P-F-0.25-DR600-DL30 / 911'406

CR20-P-CR30-P-F-0.25-DR600-0.2-DL30 / 911'406

6

['w_13', 'w_24']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'mk', 'pss', 'scce']]

CR20-P-CR30-P-F-0.25-DR600-DL30 / 911'406

CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 / 949'026

7

['w_13', 'w_26']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

CR20-P-CR30-P-F-0.25-DR600-DL30 / 911'406

CR20-P-CR30-P-F-0.3-DR600-DL60 / 930'216

8

['w_13', 'w_15']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'kld', 'pss', 'scce']]

CR20-P-CR30-P-F-0.25-DR600-DL30 / 911'406

CR32-P-CR64-P-F-0.25-DR800-DL16 / 2'556'234

9

['w_14', 'w_24']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'mk', 'pss', 'scce']]

CR20-P-CR30-P-F-0.25-DR600-0.2-DL30 / 911'406

CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 / 949'026

10

['w_14', 'w_26']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

CR20-P-CR30-P-F-0.25-DR600-0.2-DL30 / 911'406

CR20-P-CR30-P-F-0.3-DR600-DL60 / 930'216

11

['w_14', 'w_15']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'kld', 'pss', 'scce']]

CR20-P-CR30-P-F-0.25-DR600-0.2-DL30 / 911'406

CR32-P-CR64-P-F-0.25-DR800-DL16 / 2'556'234

12

['w_24', 'w_26']

[['cce', 'ck', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 / 949'026

CR20-P-CR30-P-F-0.3-DR600-DL60 / 930'216

13

['w_26', 'w_15']

[['cce', 'ck', 'kld', 'mk', 'pss', 'scce']]

[['cce', 'ck', 'kld', 'pss', 'scce']]

CR20-P-CR30-P-F-0.3-DR600-DL60 / 930'216

CR32-P-CR64-P-F-0.25-DR800-DL16 / 2'556'234

14

['w_27', 'w_02']

[['ck', 'mk']]

[['ck', 'mk']]

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60 / 930'216

CR32-P-CR64-P-F-0.35-DR1024-0.2-DL16 / 3'262'506

15

['2w_24', '2w_27']

[['cp']]

[['cp']]

CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 / 949'026 * 2

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60 / 930'216 * 2

16

['2w_24', '2w_28']

[['cp']]

[['cp']]

CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 / 949'026 * 2

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60-0.2 / 930'216 * 2

17

['2w_24', '2w_28_2']

[['cp']]

[['cp']]

CR20-P-CR30-P-F-0.3-DR600-0.2-DL52-0.2 / 949'026 * 2

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60-0.2 / 930'216 * 2

18

['2w_27', '2w_28']

[['cp']]

[['cp']]

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60 / 930'216 * 2

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60-0.2 / 930'216 * 2

19

['2w_27', '2w_28_2']

[['cp']]

[['cp']]

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60 / 930'216 * 2

CR20-P-CR30-P-F-0.3-DR600-0.2-DL60-0.2 / 930'216 * 2

20